Сценарии администрирования

Администрирование продукта СУБД Pangolin (Pangolin) (далее – Pangolin) осуществляется средствами, которые описаны в этом разделе.

Реализация АРМ администратора

Для администрирования системы используется утилита psql. Эта утилита представляет собой терминальный клиент для передачи запросов к СУБД и отображения результатов.

psql [параметр...] [имя_бд [имя_пользователя]]

Примечание:

Решение по обеспечению безопасности АРМ администратора должно исходить из окружения конечной АС.

Генерация сертификатов

Для включения SSL между компонентами кластера необходимо подготовить сертификаты.

Подготовка сертификатов не выполняется инсталлятором Pangolin. Ожидается, что на хосте уже есть сертификаты, которые будут переданы на вход инсталлятору. Инсталлятор сам разместит их в нужных директориях и выдаст права для служебных пользователей (например, etcd).

-

Серверный сертификат (необходимо создать для каждого хоста в кластере):

-

Сгенерируйте ключ:

openssl genrsa -out server.key 2048 -

Создайте файл конфигурации для создания запроса на подпись сертификата

vim server.conf:[req]

req_extensions = v3_req

distinguished_name = req_distinguished_name

[req_distinguished_name]

[ v3_req ]

basicConstraints = CA:FALSE

keyUsage = nonRepudiation, digitalSignature, keyEncipherment

subjectAltName = @alt_names

[ ssl_client ]

extendedKeyUsage = clientAuth, serverAuth

basicConstraints = CA:FALSE

subjectKeyIdentifier=hash

authorityKeyIdentifier=keyid,issuer

subjectAltName = @alt_names

[ v3_ca ]

basicConstraints = CA:TRUE

keyUsage = nonRepudiation, digitalSignature, keyEncipherment

subjectAltName = @alt_names

authorityKeyIdentifier=keyid:always,issuer

[alt_names]

DNS.1 = <host> ## hostname with domain

IP.1 = <IP-адрес> ## host ip address -

Экспортируйте файл конфигурации:

CONFIG=`echo $PWD/server.conf` -

Создайте запрос на подпись сертификата. В

CNнеобходимо указать полныйhostname:openssl req -new -key server.key -out server.csr -subj "/CN=<host>" -config ${CONFIG}

-

-

Клиентский сертификат:

-

Сгенерируйте ключ:

openssl genrsa -out postgres.key 2048 -

Создайте файл конфигурации для создания запроса на подпись сертификата

vim client.conf:[req]

req_extensions = v3_req

distinguished_name = req_distinguished_name

[req_distinguished_name]

[ v3_req ]

basicConstraints = CA:FALSE

keyUsage = nonRepudiation, digitalSignature, keyEncipherment

[ ssl_client ]

extendedKeyUsage = clientAuth

basicConstraints = CA:FALSE

subjectKeyIdentifier=hash

authorityKeyIdentifier=keyid,issuer

[ v3_ca ]

basicConstraints = CA:TRUE

keyUsage = nonRepudiation, digitalSignature, keyEncipherment

authorityKeyIdentifier=keyid:always,issuer -

Экспортируйте файл конфигурации:

CONFIG=`echo $PWD/client.conf` -

Создайте запрос на подпись сертификата. В

CNнеобходимо указать имя клиента/компонента (postgres, patroni, patronietcd, pgbouncer):openssl req -new -key postgres.key -out postgres.csr -subj "/CN=postgres" -config ${CONFIG}

Примечание:

При создании клиентских сертификатов, в поле

subjectAltNameможно указать IP-адрес или(и) DNS-имя машины (список машин), на которой(ых) будет использоваться сертификат. Также в этом поле можно указать адрес подсети. -

Сгенерированные запросы на подпись сертификатов (файлы в формате *.csr) необходимо подписать удостоверяющем центре.

Полученные сертификаты необходимо перевести в формат PEM (например, командой openssl x509 -inform DER -outform PEM -in ./certificate.cer -out ./certificate.crt), расположить в одинаковых директориях на каждом хосте и выдать права - 600 для ключей и 644 для сертификатов, владелец — УЗ ОС postgres.

Наименование сертификатов, с которыми будет работать инсталлятор:

| Назначение | Наименование сертификата | Наименование ключа |

|---|---|---|

| Сертификат сервера | server.crt | server.key |

| Сертификат пользователя postgres | postgres.crt | postgres.key |

| Сертификат пользователя Pangolin Pooler | pgbouncer.crt | pgbouncer.key |

| Сертификат пользователя patronietcd | patronietcd.crt | patronietcd.key |

| Сертификат пользователя patroni | patroni.crt | patroni.key |

Поскольку в Pangolin можно указать только один корневой сертификат, а в нашем случае их два (один — УЦ непосредственно выпустивший сертификат, второй — УЦ выпустивший сертификат для УЦ и имеющий признак CA), необходимо объединить сертификаты корневого и промежуточного УЦ в один:

cat root.crt intermediate.crt > rootCA.crt

Все корневые сертификаты необходимо скопировать в папку /etc/pki/ca-trust/source/anchors и выполнить команду обновления хранилища доверенных корневых сертификатов:

sudo update-ca-trust

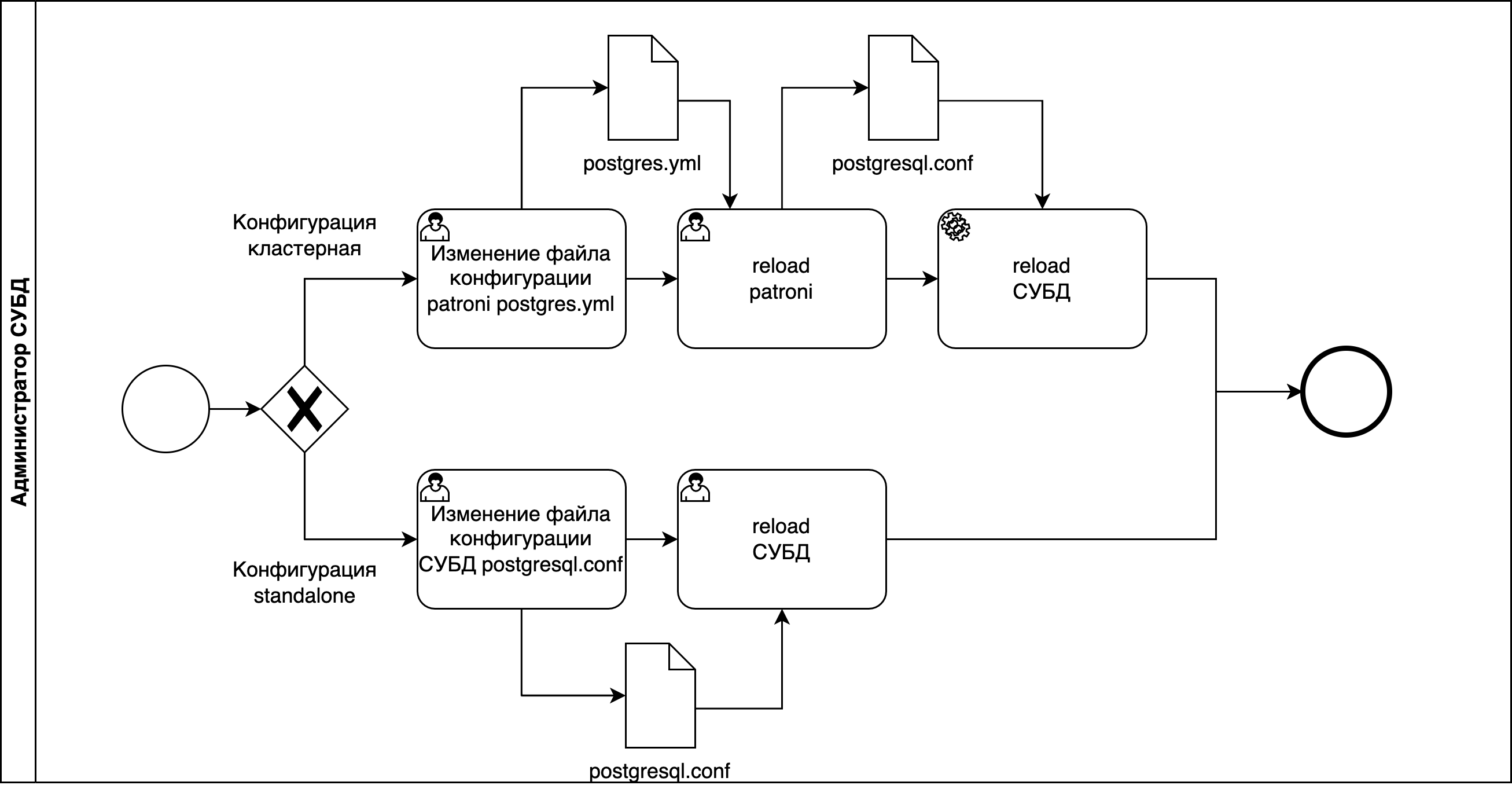

Настройка компонентов

Внимание!

В процессе работы инструмента развертывания производится валидация сертификатов на их соответствие требованиям. После работы инструмента развертывания валидация сертификатов находится на стороне владельца стенда.

Произведите настройку компонентов на использование сертификатов (задача инструмента развертывания):

-

В файле

postgres.conf(для стендов в конфигурации standalone-postgresql-pgbouncer). В данном случае необходимо указать путь к подписанным сертификатам для сервера БД:ssl = 'on'

ssl_cert_file = '/home/postgres/ca/server.crt'

ssl_key_file = '/home/postgres/ca/server.key'

ssl_ca_file = '/home/postgres/ca/rootCA.crt'

ssl_crl_file = 'путь к файлу со списком отозванных сертификатов' -

В

pangolin-pooler.iniдобавьте секцию TLS-настроек. Между Pangolin Pooler и СУБД Pangolin настраивается обязательное SSL-соединение, между Pangolin Pooler и клиентом — по требованию клиента. В обоих случаях минимальная версия TLS 1.2 (Cipher suites (TLS 1.2): ECDHE-ECDSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-ECDSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-GCM-SHA384:ECDHE-ECDSA-CHACHA20-POLY1305:ECDHE-RSA-CHACHA20-POLY1305:DHE-RSA-AES128-GCM-SHA256:DHE-RSA-AES256-GCM-SHA384).# TLS settings

server_tls_protocols = secure

server_tls_ciphers = secure

server_tls_sslmode = verify-full

server_tls_ca_file = /home/postgres/ca/rootCA.crt

server_tls_cert_file = /home/postgres/ca/pgbouncer.crt

server_tls_key_file = /home/postgres/ca/pgbouncer.key

client_tls_protocols = secure

client_tls_ciphers = secure

client_tls_sslmode = prefer

client_tls_ca_file = /home/postgres/ca/rootCA.crt

client_tls_cert_file = /home/postgres/ca/server.crt

client_tls_key_file = /home/postgres/ca/server.key -

В

etcd.confзначенияhttpпереведите вhttpsи добавьте секцию настроекTLS. Аутентификация в БД etcd происходит по паролю, так же необходимо указать сертификат пользователя.ETCD_NAME="<hostname>"

ETCD_LISTEN_CLIENT_URLS="https://<IP-адрес>:2379"

ETCD_ADVERTISE_CLIENT_URLS="<hostname>:<порт>"

ETCD_LISTEN_PEER_URLS="https://<IP-адрес>:2380"

ETCD_INITIAL_ADVERTISE_PEER_URLS="<hostname>:<порт>"

ETCD_INITIAL_CLUSTER_TOKEN="test"

ETCD_INITIAL_CLUSTER="<hostname>:<порт>,<hostname>:<порт>,<hostname>:<порт>"

ETCD_INITIAL_CLUSTER_STATE="new"

ETCD_DATA_DIR="/var/lib/etcd"

ETCD_ELECTION_TIMEOUT="5000"

ETCD_HEARTBEAT_INTERVAL="1000"

ETCD_ENABLE_V2="false"

# TLS settings

ETCD_CIPHER_SUITES="TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256,TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384"

ETCD_TRUSTED_CA_FILE="/home/postgres/ca/rootCA.crt"

ETCD_CERT_FILE="/home/postgres/ca/server.crt"

ETCD_KEY_FILE="/home/postgres/ca/server.key"

ETCD_PEER_TRUSTED_CA_FILE="/home/postgres/ca/rootCA.crt"

ETCD_PEER_CERT_FILE="/home/postgres/ca/server.crt"

ETCD_PEER_KEY_FILE="/home/postgres/ca/server.key"

ETCD_PEER_CLIENT_CERT_AUTH="true"

ETCD_PEER_CRL_FILE="путь к файлу со списком отозванных сертификатов" -

В файле конфигурации pangolin-manager

postgres.ymlвнесите изменения в секцииrestapi, etcd3, postgres, pg_hba.-

restapiдобавить параметрыverify_client, cafile, certfile, keyfile- пути до сертификатов. Параметрverify_client: optional- означает, что все запросы «управления»PUT, POST, PATCH, DELETEтребуют аутентификации по сертификатам. Параметрыallowlist: [] allowlist_include_members: true- означают, что доступ к запросам «управления» есть только у членов кластера и хостов, которые перечислены вallowlist. ЗапросыGET(только получение сведений о кластере) будут возвращаться без аутентификации.restapi:

listen: <IP-адрес>:8008

connect_address: <hostname>:<порт>

allowlist: []

allowlist_include_members: true

verify_client: optional

cafile: /home/postgres/ca/rootCA.crt

certfile: /home/postgres/ca/server.crt

keyfile: /home/postgres/ca/server.key

authentication:

username: patroniyml

password: <пароль> -

В секции

etcdдобавьте параметрыprotocol, cacert, cert, key. Соединение с etcd будет осуществляться по протоколу HTTPS.etcd:

hosts: <hostname>:<порт>,<hostname>:<порт>,<hostname>:<порт>

protocol: https

cacert: /home/postgres/ca/rootCA.crt

cert: /home/postgres/ca/patronietcd.crt

key: /home/postgres/ca/patronietcd.key

username: patronietcd

password: <пароль>

-

-

В секции postgres в подразделе аутентификации пользователя patroni добавьте параметры

sslmode, sslkey, sslcert, sslrootcertи в разделеparametersукажите путь к серверному сертификату. Параметрsslmodeустанавливается в значениеverify-caиз-за особенностей локального подключения.postgresql:

listen: <IP-адрес>:5433

bin_dir: /usr/pgsql-se-05/bin

connect_address: <hostname>:<порт>

data_dir: /pgdata/0{major_version}/data/

create_replica_methods:

- basebackup

basebackup:

format: plain

wal-method: fetch

authentication:

replication:

username: patroni

database: replication

sslmode: verify-ca

sslkey: /home/postgres/ca/patroni.key

sslcert: /home/postgres/ca/patroni.crt

sslrootcert: /home/postgres/ca/rootCA.crt

sslcrl: "путь к файлу со списком отозванных сертификатов"

superuser:

username: patroni

sslmode: verify-ca

sslkey: /home/postgres/ca/patroni.key

sslcert: /home/postgres/ca/patroni.crt

sslrootcert: /home/postgres/ca/rootCA.crt

sslcrl: "путь к файлу со списком отозванных сертификатов"

ssl: 'on'

ssl_cert_file: /home/postgres/ca/server.crt

ssl_key_file: /home/postgres/ca/server.key

ssl_ca_file: /home/postgres/ca/rootCA.crt

ssl_crl_file: "путь к файлу со списком отозванных сертификатов" -

В секции pg_hba смените метод подключения для УЗ patroni с host на hostssl:

hostssl all patroni <IP-адрес>/32 scram-sha-256

hostssl all patroni <IP-адрес>/32 scram-sha-256

hostssl replication patroni <IP-адрес>/32 scram-sha-256

hostssl replication patroni <IP-адрес>/32 scram-sha-256 -

Если какой-либо сертификат был просрочен или отозван, необходимо выпустить новый, согласно инструкции описанной в разделе «Генерация сертификатов», и, в случае изменения наименования сертификата, произвести настройку компонента, где данный сертификат был задействован. В случае сохранения имени сертификата, необходимо перезапустить сервисы компонентов после замены файлов сертификатов.

Использование сертификатов PKCS#12 в кластере Pangolin

В версиях Pangolin до 5.3.0 сертификаты и закрытые ключи, используемые для установки TLS/SSL соединений, хранились в кластере Pangolin в формате, не предусматривающем предъявление секрета для доступа к сертификату и/или закрытому ключу. В версии Pangolin, начиная с 5.3.0, в целях повышения уровня информационной безопасности вводится авторизация для использования сертификатов и закрытых ключей на промышленных стендах.

При использовании оригинального libpq поддержка PKCS#12 недоступна, так как не гарантируется работоспособность сторонних решений.

Сертификаты и закрытые ключи, используемые в версии Pangolin 5.2.1, приведены в таблице ниже и используются для установления TLS-соединения между компонентами кластера Pangolin:

| Клиентские сертификат и ключ Pangolin Pooler для подключения к серверу СУБД Pangolin | Назначение сертификатов и закрытых ключей |

|---|---|

| server.crt / server.key | Серверный сертификат СУБД Pangolin для установления клиентских подключений Серверный сертификат Pangolin Manager. для установления клиентских подключений (REST API) Клиентский и серверный сертификат для взаимодействия между экземплярами etcd Серверный сертификат Pangolin Pooler для установления клиентских подключений |

| pgbouncer.crt / pgbouncer.key | Клиентский сертификат Pangolin Pooler для подключения к серверу СУБД Pangolin |

| patroni.crt / patroni.key | Клиентский сертификат Pangolin Manager для подключения к серверу СУБД Pangolin |

| patronietcd.crt / patronietcd.key | Клиентский сертификат Pangolin Manager для подключения к серверу etcd |

| client.crt / client.key | Клиентский сертификат пользователя postgres |

| root.crt | Корневой сертификат УЦ |

С версии Pangolin 5.3.0 данные сертификаты и закрытые ключи, за исключением root.crt и patronietcd.crt/patronietcd.key, хранятся в файловой системе в засекреченных контейнерах PKCS#12, а парольные фразы для их расшифровки - в засекреченном виде. Ключ для засекречивания/рассекречивания парольных фраз генерируется на основе параметров сервера, поэтому файлы с парольными фразами не переносимы между узлами кластера Pangolin.

Примечание:

Следующая ключевая информация хранится в файловой системе в PEM-формате:

- Сертификаты и закрытые ключи etcd (

etcd.crt/etcd.key,patronietcd.crt/patronietcd.key), так как этот компонент не поддерживается командой разработки Pangolin.- Корневой сертификат, которым подписаны сертификаты etcd (может не совпадать с сертификатом, подписавшим сертификаты компонентов Pangolin, Pangolin Pooler и Pangolin Manager).

- Корневой сертификат

root.crt, которым подписаны сертификаты компонентов Pangolin, Pangolin Pooler и Pangolin Manager.

Для компонентов кластера введены настроечные параметры для установки пути до конфигурационного файла, включающего путь к контейнеру PKCS#12 и парольную фразу в засекреченном виде:

-

в конфигурационном файле pangolin-manager

postgresql.ymlпараметрpkcs12_config_pathв секциях:-

restapi:pkcs12_config_path: example.p12.cfg;

-

postgresql:authentication:replication/superuser/rewind:pkcs12_config_path: example.p12.cfg;

-

postgresql:parameters:serverssl.pkcs12_config_path: example.p12.cfg;

-

-

в конфигурационном файле СУБД Pangolin

postgresql.confпараметрserverssl.pkcs12_config_path; -

в конфигурационном файле Pangolin Pooler

pangolin-pooler.iniпараметрыclient_tls_pkcs12_config_pathиserver_tls_pkcs12_config_path; -

в строке подключения

psql:pkcs12_config_path(переменная окруженияPKCS12_CONFIG_PATH);pkcs12_passphrase(переменная окруженияPKCS12_PASSPHRASE) - используется для предоставления парольной фразы без ручного ввода в случае, если в файле.p12.cfgотсутствует поле passphrase. Парольная фраза может быть как в открытом, так и в засекреченном виде. Парольная фраза засекречивается утилитойpg_auth_password.

Формат конфигурационного файла .p12.cfg:

{

"pkcs12": "", // Путь к контейнеру PKCS#12

"passphrase": "" // Парольная фраза, засекреченная ключом на параметрах сервера, либо в открытом виде

}

Для валидации сертификатов компонентов, выполняющих подключение, по умолчанию используется полная цепочка сертификатов в контейнере PKCS#12, если в конфигурационных файлах не прописаны прежние параметры для установки цепочки доверенных сертификатов:

-

в конфигурационном файле Pangolin Manager

postgresql.ymlв секциях:-

restapi:cafile: /path/to/CAfile.pem;capath: /path/to/CAdir(параметр введен в версии 5.3.0);

-

postgresql:authentication:replication/superuser/rewind:sslrootcert: /path/to/CAfile.pem;sslrootpath: /path/to/CAdir(параметр введен в версии 5.3.0);

-

postgresql:parameters:ssl_ca_file: /path/to/CAfile.pem;ssl_ca_path: /path/to/CAdir(параметр введен в версии 5.3.0);

-

-

в конфигурационном файле СУБД Pangolin

postgresql.conf:ssl_ca_file = '/path/to/CAfile.pem';ssl_ca_path = '/path/to/CAdir'(параметр введен в версии 5.3.0);

-

в конфигурационном файле Pangolin Pooler

pangolin-pooler.ini:client_tls_ca_file = /path/to/CAfile.pem;server_tls_ca_file = /path/to/CAfile.pem;client_tls_ca_path = /path/to/CAdir(параметр введен в версии 5.3.0);server_tls_ca_path = /path/to/CAdir(параметр введен в версии 5.3.0);

-

в строке подключения

psql:sslrootcert = /path/to/CAfile.pem(переменная окруженияPGSSLROOTCERT);sslrootpath = /path/to/CAdir(переменная окруженияPGSSLROOTPATH(параметр введен в версии 5.3.0)).

Если один из этих параметров указан, то он будет использоваться для инициализации цепочки доверенных сертификатов для проверки сертификатов: со стороны сервера - клиентского сертификата, со стороны клиента - серверного сертификата. В дополнение к приведенным вариантам поиска доверенных сертификатов добавлен поиск среди доверенных сертификатов операционной системы. Настроечный параметр для этого не требуется.

Примечание:

Клиентские компоненты кластера (

psql) используют полную цепочку сертификатов в контейнере PKCS#12 для валидации сертификатов, если в строке подключения параметрsslmodeустановлен вverify-caилиverify-full.

Порядок поиска доверенных сертификатов:

- если не используются параметры, указывающие на файл, либо директорию с сертификатами: сначала в полной цепочке сертификатов из контейнера PKCS#12, затем в директории ОС, указанной по умолчанию;

- если используются параметры, указывающие на файл и/или директорию с сертификатами: сначала в файле, содержащем один или несколько доверенных сертификатов, затем в директории, если установлена, и, если в них не удалось найти нужный сертификат, то - в директории ОС, указанной по умолчанию.

Возможность конфигурирования сертификатов через PEM-файлы сохранена.

Реализация интерфейса получения контейнера PKCS#12 и парольной фразы к нему выполнена в виде плагинов (подключаемых модулей). В директории установки Pangolin созданы символические ссылки на плагины:

/usr/pangolin-{version}/lib/libpkcs12_exporter_plugin_link.so -> plugins/libpkcs12_exporter_plugin.so

/usr/pangolin-{version}/lib/libpkcs12_passphrase_plugin_link.so -> plugins/libpkcs12_passphrase_plugin.so

Для контроля сроков действия сертификатов и проверки подписи локальным корневым сертификатом в контейнерах PKCS#12 предоставляется утилита pkcs12_cert_info. По умолчанию поиск корневого сертификата также ведется в системных директориях по умолчанию. Утилита принимает на вход аргументы: путь к конфигурационному файлу со стратегией получения контейнера PCKS#12 и парольной фразы --pkcs12_config_path (-p), параметр включения проверки подписи --verify (-v), опционально путь к корневому сертификату --CAfile (-f), опционально путь к директории с корневым сертификатом --CApath (-d), опциональный параметр отключения поиска в директориях по умолчанию --no-CApath (-n).

Утилита pkcs12_cert_info доступна только для редакций Enterprise и Enterprise для ERP-систем.

Справка по использованию утилиты:

$ pkcs12_cert_info -h

Usage:

pkcs12_cert_info <option>...

Options:

--help [-h] This help

--pkcs12_config_path [-p] Path to config file with info how to get PKCS#12 file

--verify [-v] Check that PKCS#12 certificate trusted by anchor

--CAfile [-f] Path to root/intermediate certificate file

--CApath [-d] Path to root/intermediate certificate directory

--no-CApath [-n] Do not use the default directory of trusted certificates.

Pangolin product version information:

--product_version prints product name and version

--product_build_info prints product build number, date and hash

--product_component_hash prints component hash string

Вывод утилиты включает статус наличия закрытого ключа в контейнере, сроки действия сертификата и атрибуты, идентифицирующие сертификат (имя издателя и общее имя сертификата), а также сроки действия цепочки доверенных сертификатов. При введенном параметре проверки подписи выводится результат проверки, а также путь до использованного корневого сертификата.

Пример запуска утилиты:

$ pkcs12_cert_info -p /pg_ssl/server.p12.cfg

Certificate:

Issuer: CN=Pangolin_intermediate_CA

Validity

Not Before: Nov 8 10:52:13 2022 GMT

Not After : Nov 5 10:52:13 2032 GMT

Subject: CN=srv-0-154

Private key exists

Certificate chain:

Certificate #1:

Issuer: CN=Pangolin_CA

Validity

Not Before: Nov 8 10:52:13 2022 GMT

Not After : Nov 5 10:52:13 2032 GMT

Subject: CN=Pangolin_intermediate_CA

Certificate #2:

Issuer: CN=Pangolin_CA

Validity

Not Before: Nov 8 10:52:12 2022 GMT

Not After : Nov 5 10:52:12 2032 GMT

Subject: CN=Pangolin_CA

Использование сертификатов в локально хранящихся контейнерах PKCS#12 настраивается путем установки следующих параметров в конфигурационных файлах компонентов кластера:

- в конфигурационном файле Pangolin Manager

postgresql.ymlпараметрpkcs12_config_pathв секциях:restapi;pkcs12_config_path: example.p12.cfg;

postgresql:authentication:replication/superuser/rewind;pkcs12_config_path: example.p12.cfg;

postgresql:parameters;serverssl.pkcs12_config_path: example.p12.cfg;

- в конфигурационном файле СУБД Pangolin

postgresql.confпараметрserverssl.pkcs12_config_path; - в конфигурационном файле Pangolin Pooler

pangolin-pooler.iniпараметрыclient_tls_pkcs12_config_pathиserver_tls_pkcs12_config_path.

Изменение данных параметров не требует перезапуска компонентов кластера, достаточно выполнить перечитывание конфигурационных файлов.

Если для подключения к СУБД Pangolin требуется предоставить сертификат, и кластер настроен с использованием контейнеров PKCS#12, хранящихся в файловой системе, то в строке подключения psql необходимо указать параметр pkcs12_config_path с путем до конфигурационного файла .p12.cfg, содержащего путь к контейнеру PKCS#12 и парольную фразу в засекреченном виде.

Примеры запуска утилиты psql:

# В файле /pg_ssl/client.p12.cfg установлена парольная фраза.

$ psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full pkcs12_config_path=/pg_ssl/client.p12.cfg"

# В файле /pg_ssl/client.p12.cfg установлена парольная фраза. Путь к /pg_ssl/client.p12.cfg указан через переменную окружения.

$ PKCS12_CONFIG_PATH=/pg_ssl/client.p12.cfg psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full"

# В файле /pg_ssl/client.p12.cfg парольная фраза не установлена. Парольная фраза передается в строке подключения в засекреченном виде.

$ psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full pkcs12_config_path=/pg_ssl/client.p12.cfg pkcs12_passphrase=$enc$+tsiUlhEuNw4ASyvN6ta0A==$sys$mKb2BejR/MLUBzZQ2PaFs+zXGHDRljMWqX46w0CMmDWtjPDzwbxwNSfDAmVTT3Wu"

# В файле /pg_ssl/client.p12.cfg парольная фраза не установлена. Парольная фраза передается через переменную окружения в засекреченном виде.

$ PKCS12_PASSPHRASE='$enc$+tsiUlhEuNw4ASyvN6ta0A==$sys$mKb2BejR/MLUBzZQ2PaFs+zXGHDRljMWqX46w0CMmDWtjPDzwbxwNSfDAmVTT3Wu' psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full pkcs12_config_path=/pg_ssl/client.p12.cfg"

# В файле /pg_ssl/client.p12.cfg парольная фраза не установлена. Требуется ручной ввод парольной фразы.

$ psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full pkcs12_config_path=/pg_ssl/client.p12.cfg"

Enter passphrase for PKCS#12 file:

***

Внимание!

В режиме защищенного конфигурирования (

secure_config = on) управление параметром СУБД Pangolinserverssl.pkcs12_config_pathвыполняется на стороне хранилища секретов.

Если для валидации сертификатов не подходит полная цепочка сертификатов в контейнере PKCS#12, предоставляется возможность использования существующих параметров для установки путей к файлам с полными цепочками доверенных сертификатов или введенных в текущей работе новых параметров для установки директории с доверенными сертификатами:

- в конфигурационном файле Pangolin Manager.

postgresql.ymlв секциях:restapi;cafile: /path/to/CAfile.pem;capath: /path/to/CAdir;

postgresql:authentication:replication/superuser/rewind;sslrootcert: /path/to/CAfile.pem;sslrootpath: /path/to/CAdir;

postgresql:parameters;ssl_ca_file: /path/to/CAfile.pem;ssl_ca_path: /path/to/CAdir;

- в конфигурационном файле СУБД Pangolin

postgresql.conf:ssl_ca_file = '/path/to/CAfile.pem';ssl_ca_path = '/path/to/CAdir';

- в конфигурационном файле Pangolin Pooler

pangolin-pooler.ini:client_tls_ca_file = /path/to/CAfile.pem;server_tls_ca_file = /path/to/CAfile.pem;client_tls_ca_path = /path/to/CAdir;server_tls_ca_path = /path/to/CAdir;

- в строке подключения

psql:sslrootcert = /path/to/CAfile.pem(переменная окруженияPGSSLROOTCERT);sslrootpath = /path/to/CAdir(переменная окруженияPGSSLROOTPATH).

Поиск доверенных сертификатов также выполняется среди доверенных сертификатов операционной системы. Настроечный параметр для этого не требуется.

Пример подготовки директории с доверенными сертификатами:

# Добавление корневого сертификата в директорию с доверенными сертификатами

cp /path/to/panglolin.crt /pg_ssl/root_dir

c_rehash /pg_ssl/root_dir

Пример управления доверенными сертификатами операционной системы CentOS 7.9:

# Добавление корневого сертификата с именем Pangolin_CA в хранилище доверенных сертификатов ОС

sudo cp /path/to/panglolin.crt /etc/pki/ca-trust/source/anchors/

sudo update-ca-trust extract

trust list|grep Pangolin_CA

# Удаление корневого сертификата с именем Pangolin_CA из хранилища доверенных сертификатов ОС

sudo rm /etc/pki/ca-trust/source/anchors/panglolin.crt

sudo update-ca-trust extract

trust list|grep Pangolin_CA

Для контроля сроков действия сертификатов в контейнерах PKCS#12 предоставляется утилита pkcs12_cert_info. Утилита принимает на вход один аргумент: путь к конфигурационному файлу со стратегией получения контейнера PCKS#12 и парольной фразы. Вывод утилиты включает статус наличия закрытого ключа в контейнере, сроки действия сертификата и атрибуты, идентифицирующие сертификат (имя издателя и общее имя сертификата), а также сроки действия полной цепочки сертификатов.

В пользовательском конфигурационном файле инсталлятора введены следующие параметры:

-

Контейнер PKCS#12, помимо сертификата и закрытого ключа, может содержать полную цепочку сертификатов, включая корневой, которыми подписан сертификат. Для упрощения настройки доверенных SSL/TLS сертификатов в кластере предоставляется возможность использовать цепочку сертификатов из контейнера в качестве доверенных, установив параметр pkcs12_use_ca_chain_from_container в true.

# Флаг определяет, использовать ли полную цепочку сертификатов в контейнере PKCS#12 в качестве доверенной.

# Если флаг true, то использовать полную цепочку доверенных сертификатов в контейнере, если есть, в качестве доверенной, иначе - false.

pkcs12_use_ca_chain_from_container: true -

Если вариант с использованием полной цепочки сертификатов из контейнера PKCS#12 не подходит для настройки доверенных SSL/TLS сертификатов, предоставляется возможность установки доверенных сертификатов через следующие параметры:

pg_certs_pwd:

root_ca_file: "{{ '' | default('/pg_ssl/root.crt', true) }}" # Использовать PEM файл, который может содержать один или несколько доверенных сертификатов

root_ca_path: "{{ '' | default('/pg_ssl/root_dir', true) }}" # Использовать подготовленную директорию с доверенными сертификатами -

Параметры для поддержки использования сертификатов и закрытых ключей из контейнеров PKCS#12, расположенных в файловой системе:

# Активация получения контейнера PKCS#12 и парольной фразы к нему из файловой системы.

# Если флаг true, то устанавливаются плагины libpkcs12_passphrase_plugin.so и libpkcs12_exporter_plugin.so.

# Если флаг false, то используется прежний подход для получения ключевой информации: из файлов в PEM формате. Плагин не устанавливается.

pkcs12_plugin_enable: true

pg_certs_pwd:

# Установка параметра p12_path обязательна при активации флага pkcs12_plugin_enable.

server_p12:

p12_path: "{{ '' | default('/home/postgres/ssl/server.p12', true) }}" # Путь в файловой системе к контейнеру PKCS#12 с серверной ключевой парой и цепочкой доверенных сертификатов.

p12_pass: "{{ '' | default('', true) }}" # Парольная фраза для доступа к контейнеру PKCS#12 (server.p12), засекреченная средствами Ansible Vault (в ходе установки парольная фраза рассекречивается и сохраняется в файл по пути p12_config_path (см. ниже) в засекреченном виде на ключе, сгенерированном на параметрах сервера). Параметр обязателен в случае установки параметра p12_path.

p12_config_path: "{{ '' | default('/home/postgres/ssl/server.p12.cfg', true) }}" # Путь к файлу в JSON-формате, содержащему параметр ("passphrase") для получения парольной фразы для доступа к контейнеру PKCS#12, засекреченную на ключе, сгенерированном на параметрах сервера, и параметр ("pkcs12") для получения контейнера PKCS#12. Параметр обязателен при установке флага pkcs12_plugin_enable в true.

postgres_p12:

p12_path: "{{ '' | default('/home/postgres/ssl/client.p12', true) }}" # Путь в файловой системе к контейнеру PKCS#12 с клиентской ключевой парой пользователя postgres и цепочкой доверенных сертификатов

p12_pass: "{{ '' | default('', true) }}"

p12_config_path: "{{ '' | default('/home/postgres/ssl/client.p12.cfg', true) }}"

pgbouncer_p12:

p12_secman_integration: true

p12_path: "{{ '' | default('/home/postgres/ssl/pgbouncer.p12', true) }}" # Путь в файловой системе к контейнеру PKCS#12 с клиентской ключевой парой Pangolin Pooler и цепочкой доверенных сертификатов для подключения к СУБД Pangolin

p12_pass: "{{ '' | default('', true) }}"

p12_config_path: "{{ '' | default('/home/postgres/ssl/pgbouncer.p12.cfg', true) }}"

patroni_p12:

p12_path: "{{ '' | default('/home/postgres/ssl/patroni.p12', true) }}" # Путь в файловой системе к контейнеру PKCS#12 с клиентской ключевой парой и цепочкой доверенных сертификатов для подключения Pangolin Manager к СУБД Pangolin

p12_pass: "{{ '' | default('', true) }}"

p12_config_path: "{{ '' | default('/home/postgres/ssl/patroni.p12.cfg', true) }}"

etcd_cert: "{{ '' | default('/home/postgres/ssl/etcd.crt', true) }}" # Путь к сертификату для взаимодействия экземпляров ETCD. Может быть подписан сертификатом, отличным от сертификата, подписавшего сертификаты компонентов Pangolin, Pangolin Pooler, Pangolin Manager. Тогда потребуется указать путь к корневому сертификату в параметре etcd_root_ca.

etcd_key: "{{ '' | default('/home/postgres/ssl/etcd.key', true) }}" # Путь к приватному ключу для взаимодействия экземпляров ETCD

etcd_root_ca: "{{ '' | default('/home/postgres/ssl/root_etcd.crt', true) }}" # Корневой сертификат для проверки действительности сертификатов ETCDПримечания к ключам словаря

pg_certs_pwd:-

p12_path- путь в файловой системе к контейнеру PKCS#12 с ключевой парой и цепочкой доверенных сертификатов. -

p12_pass- парольная фраза для доступа к контейнеру PKCS#12, засекреченная средствами Ansible Vault. В ходе установки парольная фраза рассекречивается и сохраняется в файл по путиp12_config_pathв засекреченном виде на ключе, сгенерированном на параметрах сервера. -

p12_config_path- путь к файлу в JSON-формате.p12.cfg, содержащему поле "passphrase" с парольной фразой для доступа к контейнеру PKCS#12 и полеpkcs12с путем до контейнера PKCS#12. Файл формируется инсталлятором: в полеpkcs12прописывается путь к контейнеру PKCS#12 (из параметраp12_path), в полеpassphraseпомещается парольная фраза перекодированная ключом, сгенерированном на основе параметров сервера (из параметраp12_pass). Формат файла:{

"pkcs12": "", // Путь к контейнеру PKCS#12

"passphrase": "" // Парольная фраза, засекреченная ключом на параметрах сервера, либо в открытом виде

} -

etcd_root_ca- путь к корневому сертификату ETCD. Параметр является обязательным при настройке SSL между узлами etcd.

-

-

Параметр для выбора способа хранения парольной фразы в конфигурационном файле

.p12.cfg, путь к которому указывается в параметреp12_config_path: в засекреченном или в открытом виде.# Флаг, определяющий способ хранения парольной фразы к контейнеру PKCS#12.

# Если флаг true, то парольная фраза засекречивается ключом, генерируемым на основе параметров сервера, иначе - парольная фраза в открытом виде.

pkcs12_encrypt_passphrase: true

Отключение функциональности

Отключение функциональности выполняется переконфигурированием кластера на использование сертификатов в PEM-формате без перезапуска кластера. Достаточно выполнить перечитывание конфигурационных файлов.

Управление сертификатами для Pangolin с Secret Management System

В целях повышения уровня информационной безопасности новая функциональность обеспечивает хранение и использование контейнеров PKCS#12 и парольных фраз к ним в хранилище секретов и сертификатов Secret Management System (SecMan) и их ротацию на промышленных стендах.

В Pangolin появляется несколько новых конфигурационных файлов. Эти файлы используются следующими компонентами кластера: СУБД Pangolin, Pangolin Pooler и Pangolin Manager. Каждый компонент использует свой конфигурационный файл. Данные, указанные в файлах, используются для генерации контейнеров PKCS#12, содержащих сертификат и частный ключ. Контейнер создается и хранится в SecMan и возвращается компоненту кластера по запросу.

Описание файла:

{

"pkcs12": {

"name": "", // Имя роли

"common_name": "", // CN для сертификата

"email": "", // Почтовый адрес владельца сертификата

"alt_names": "", // Альтернативные имена субъектов в списке, разделенном запятыми. Это могут быть имена хостов или адреса электронной почты

"ip_sans": "", // Альтернативные имена субъекта IP в списке с разделителями-запятыми. Действителен только в том случае, если роль разрешает IP SAN (по умолчанию)

"other_sans": "", // Настраиваемые SAN со строкой OID/UTF8

"exclude_cn_from_sans": "" // Параметр, включающий/выключающий возможность исключить common_name из DNS или электронной почты SAN

}

}

Примеры файлов для компонентов кластера:

-

Pangolin:

{

"pkcs12": {

"name": "server",

"common_name": "server",

"email": "test@test.ru",

"alt_names": "",

"ip_sans": "",

"other_sans": "",

"exclude_cn_from_sans": ""

}

} -

Pangolin Pooler:

{

"pkcs12": {

"name": "pgbouncer",

"common_name": "pgbouncer",

"email": "test@test.ru",

"alt_names": "",

"ip_sans": "",

"other_sans": "",

"exclude_cn_from_sans": ""

}

} -

Pangolin Manager:

{

"pkcs12": {

"name": "patroni",

"common_name": "patroni",

"email": "test@test.ru",

"alt_names": "",

"ip_sans": "",

"other_sans": "",

"exclude_cn_from_sans": ""

}

}

Для того, чтобы использовать новые конфигурационные файлы, пути к ним нужно прописать в основных конфигурационных файлах:

-

В случае кластера. В файле конфигурации Pangolin Manager

postgresql.ymlв параметреpkcs12_config_pathв секцияхrestapi,postgresql/authentication/replication,postgresql/authentication/superuserиpostgresql/authentication/rewind, а также в параметреpkcs12_config_pathв секцииpostgresql/parameters:restapi:

pkcs12_config_path: "" # Путь к конфигурационному файлу в JSON-формате, содержащему данные для генерации сертификата

postgresql:

authentication:

replication:

pkcs12_config_path: "" # Путь к конфигурационному файлу в JSON-формате, содержащему данные для генерации сертификата

postgresql:

authentication:

superuser:

pkcs12_config_path: "" # Путь к конфигурационному файлу в JSON-формате, содержащему данные для генерации сертификата

postgresql:

authentication:

rewind:

pkcs12_config_path: "" # Путь к конфигурационному файлу в JSON-формате, содержащему данные для генерации сертификата

postgresql:

parameters:

serverssl.pkcs12_config_path: "" # Путь к конфигурационному файлу в JSON-формате, содержащему данные для генерации сертификата -

В случае standalone конфигурации. В файле конфигурации СУБД Pangolin

postgresql.conf(для случая конфигурации standalone) в параметреserverssl.pkcs12_config_path:serverssl.pkcs12_config_path = "" # Путь к конфигурационному файлу в JSON-формате, содержащему данные для генерации сертификатаВнимание!При включенной защите параметров конфигурационный параметр

serverssl.pkcs12_config_pathдолжен быть под защитой, а его значение должно устанавливаться только через SecMan. -

В файле конфигурации Pangolin Pooler

pangolin-pooler.iniв параметреclient_tls_pkcs12_config_pathиserver_tls_pkcs12_config_path:client_tls_pkcs12_config_path = "" # Путь к конфигурационному файлу в JSON-формате, содержащему данные для генерации сертификата

server_tls_pkcs12_config_path = "" # Путь к конфигурационному файлу в JSON-формате, содержащему данные для генерации сертификата

Ротация сертификатов, получаемых из SecMan

Ротация сертификатов, используемых компонентами кластера, осуществляется агентом, который:

- контролирует срок действия сертификатов, полученных из SecMan;

- обновляет сертификаты на SecMan при приближении конца их срока действия;

- контролирует внешнее изменение сертификатов, обновление на SecMan, а также отзыв сертификата;

- запускает процесс обновления сертификатов на кластере.

Функциональность доступна только для редакций Enterprise и Enterprise для ERP-систем.

Агент pangolin-certs-rotate

Агент представляет собой исполняемый файл pangolin-certs-rotate, который настраивается для работы с конкретным хранилищем сертификатов через систему плагинов. Расположен в директории /opt/pangolin-common/bin/ и запускается отдельной службой pangolin-certs-rotate.service до запуска служб postgresql.service, pangolin-pooler.service и pangolin-manager.service.

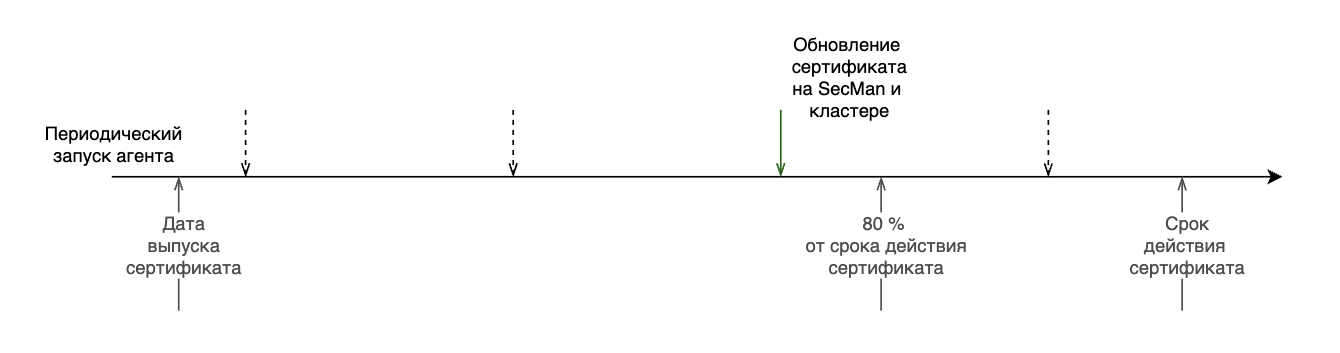

Период проверки сертификатов и их обновления настраивается в конфигурационном файле агента. Первая проверка происходит на его старте. Следующий запуск агента может произойти до окончания заданного промежутка времени, если интервал между датой истечения и датой выпуска одного из сертификатов достигает 80% внутри текущего периода. Таким образом, агент будет запущен в этот момент времени, и следующий период будет отсчитываться уже от этой точки. Если в процессе работы агента произошла ошибка, то его следующий запуск произойдет через заданный в конфигурации период ожидания.

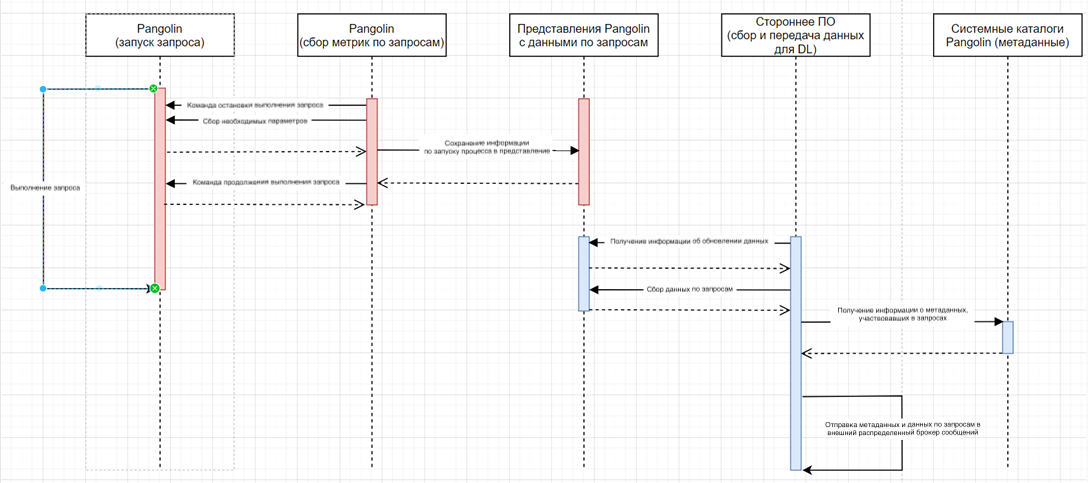

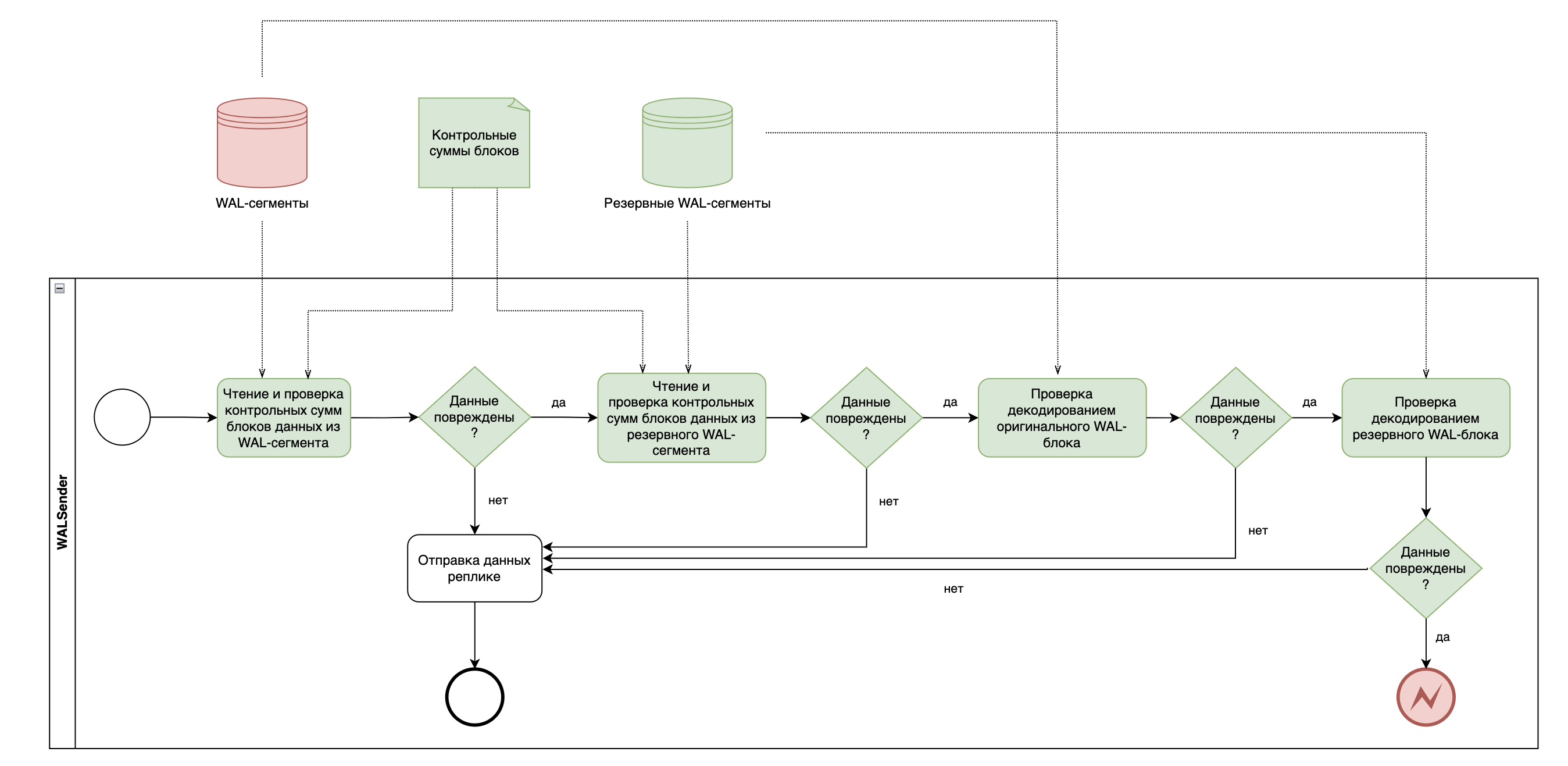

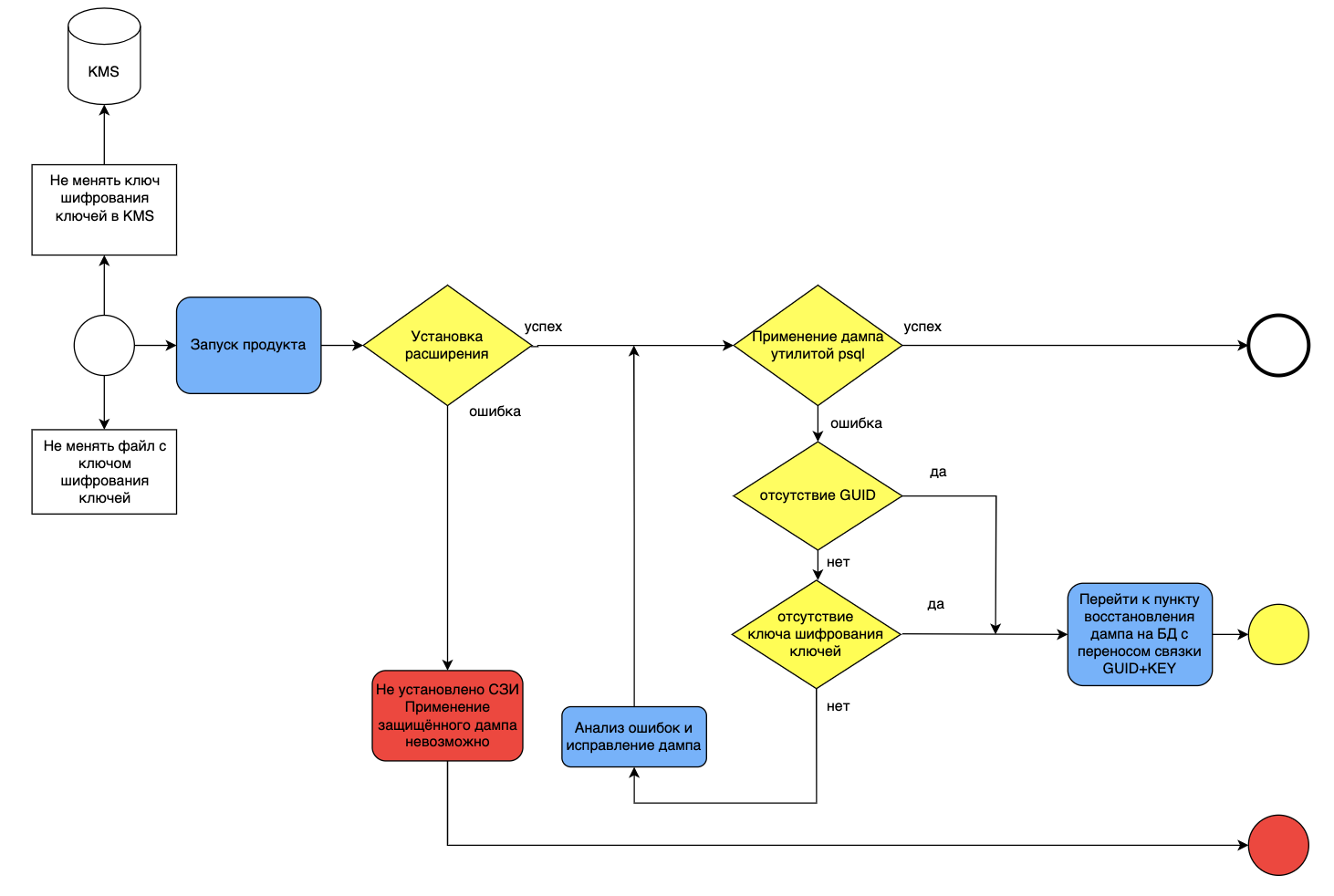

На схеме ниже приведены этапы работы агента:

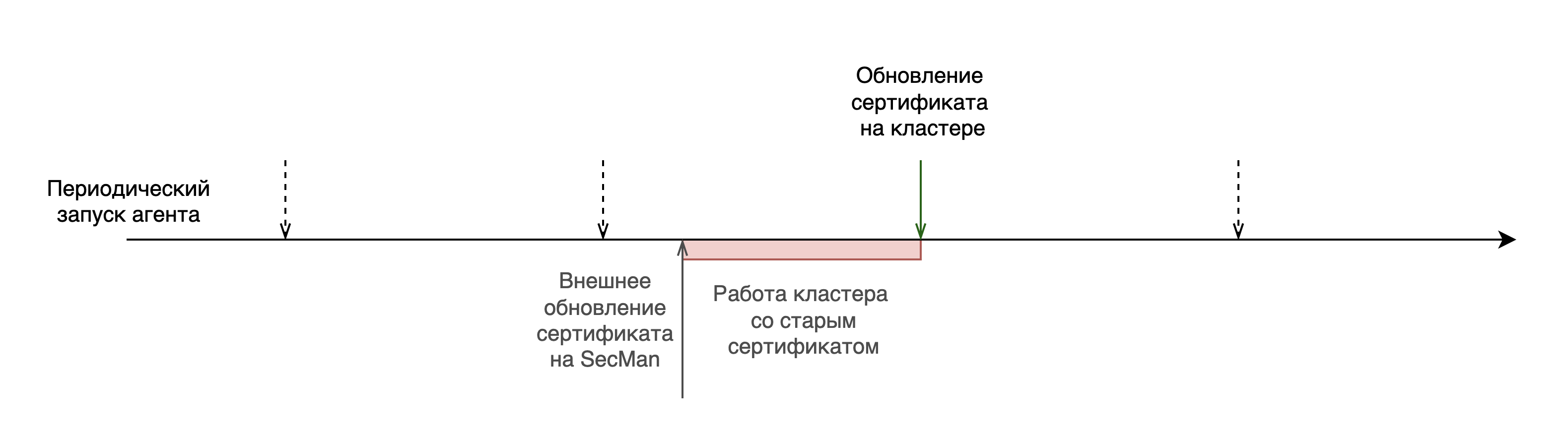

Если обновление сертификата на SecMan произошло без участия агента, то кластер до следующего запуска агента будет работать со старым сертификатом (в том числе, если сертификат отозван):

Для взаимодействия с SecMan применяется плагин remote_secman_pki_plugin, который использует протокол http/https, а также параметры подключения кластера. Параметры хранятся в засекреченном хранилище /etc/pangolin-security-utilities/enc_connection_settings_cert.cfg. Для рассекречивания файла агент использует плагин кодирования.

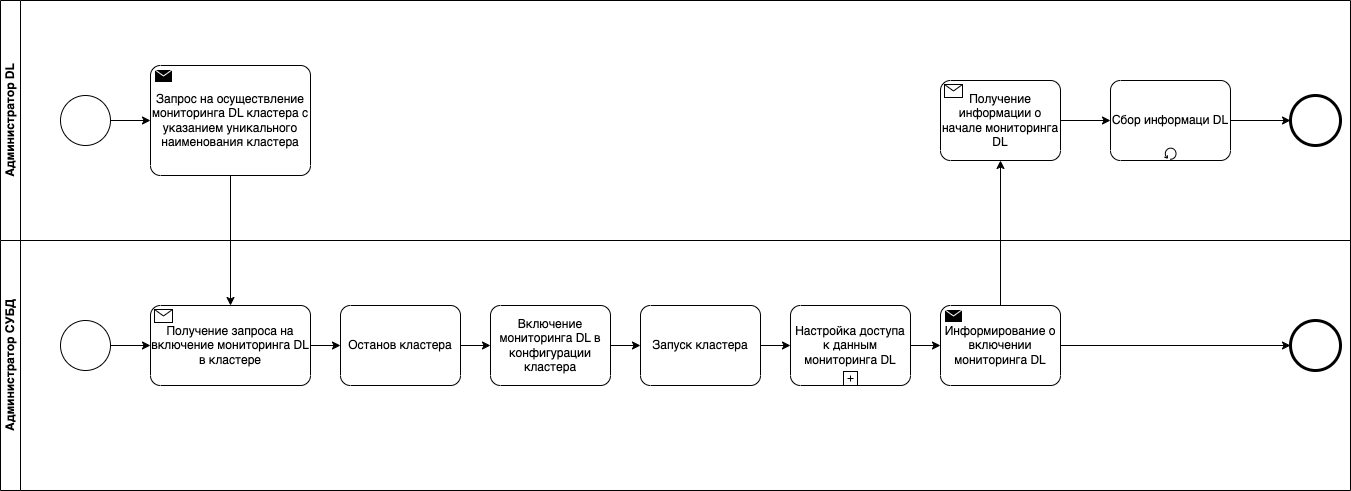

Процесс инсталляции агента

Настройка работы агента происходит на этапе установки кластера Pangolin (при автоматизированном способе установки):

При ручной установке требуется установить rpm/deb-пакет компонента, при помощи пакетного менеджера, и проделать действия по инициализации - вручную.

Для включения агента ротации сертификатов в конфигурационном файле инсталлятора custom_file_template.yml требуется добавить параметр enable в yaml-словарь pangolin-certs-rotate. Все параметры агента сохраняются в конфигурационном файле, который тот использует при инициализации:

-

путь к конфигурационному файлу агента задается при помощи параметра

agent_config, который находится вpangolin-certs-rotate. По умолчанию используется конфигурационный файл/etc/pangolin-certs-rotate/pangolin-certs-rotate.yml; -

путь к директории для лог-файлов задается с помощью параметра

log_directoryв yaml-словареpangolin-certs-rotate. По умолчанию используется путь/var/log/pangolin-certs-rotate; -

имя лог-файла задается параметром

log_filenameв yaml-словареpangolin-certs-rotate. По умолчанию используется имя pangolin-certs-rotate; -

уровень логирования задается параметром

log_levelв yaml-словареpangolin-certs-rotate. Возможны уровни:debug | info | warning | error | fatal. По умолчанию используется уровеньinfo; -

методы записи лога задаются параметром

log_destinationв yaml-словареpangolin-certs-rotate. Возможные методы:console, fileпри любой комбинации методов. По умолчанию используется методconsole; -

включить/отключить функцию ротации сертификатов можно с помощью параметра

enable_updateв словареpangolin-certs-rotate:certs. По умолчанию функция включена; -

период проверки сертификатов настраивается при помощи параметра

poll_period_in_min, который находится в словареpangolin-certs-rotate:certsи задается в минутах. По умолчанию период работы будет равен 60 минутам; -

время ожидания повторного запуска агента в случае ошибки устанавливается в параметре

retry_interval_in_sec, который находится в словареpangolin-certs-rotate:certsи задается в секундах. По умолчанию тайм-аут будет равен 30 секундам; -

количество повторных проверок в случае ошибки задается параметром

retry_attempts_num, который находится в словареpangolin-certs-rotate:certs. По умолчанию настроена одна попытка; -

список сертификатов, за сроком действия которых «следит» агент, определяются группами

locations, которые находятся в словареpangolin-certs-rotate:certs:watch. В каждой группе задается:-

в словаре

pathsмножество конфигурационных файлов сертификатов*.p12.cfg; -

в словаре

on_updateмножество зависимых от сертификатов команд, необходимых для обновления компонентов кластера.Внимание!Были реализованы только следующие команды:

sudo systemctl reload postgresql

sudo systemctl reload pangolin-manager

sudo systemctl reload pangolin-pooler

-

Формат конфигурационного файла инсталлятора для агента ротации:

pg-certs-rotate-agent:

# Флаг определяет, запускается ли агент ротации.

# Если флаг true, то агент будет запущен, иначе - false.

enable: true

# Путь к конфигурационному файлу агента в YAML-формате

agent_config: "{{ '' | default('/etc/pangolin-certs-rotate/pangolin-certs-rotate.yml', true) }}"

# Путь к директории для лог-файлов

log_directory: "{{ '' | default('/var/log/pangolin-certs-rotate', true) }}"

# Имя лог-файла

log_filename: "{{ '' | default('pangolin-certs-rotate', true) }}"

# Уровень логирования

log_level: "{{ '' | default('info', true) }}"

# Методы записи лога

log_destination: "{{ '' | default('console', true) }}"

certs:

# Включить/выключить автоматическое обновление сертификатов

enable_update: "{{ '' | default(true, true) }}"

# Период проверки валидности сертификатов [мин]

poll_period_in_min: "{{ '' | default(60, true) }}"

# Тайм-аут на повторный запуск в случае ошибки [c]

retry_interval_in_sec: "{{ '' | default(30, true) }}"

# Количество попыток после неудачи

retry_attempts_num: "{{ '' | default(1, true) }}"

# Множество обновляемых сертификатов

watch:

- locations:

# Множество файлов конфигураций сертификатов

paths:

- path/to/cert/configuration/1_1

- path/to/cert/configuration/1_N

# Множество команд, которые требуется выполнить после обновления хотя бы одного из сертификатов

on_update:

- update command 1_1

- update command 1_N

# Множество файлов конфигураций

- locations:

# Множество обновляемых сертификатов

paths:

- path/to/cert/configuration/M_1

- path/to/cert/configuration/M_N

# Множество команд, которые требуется выполнить после обновления хотя бы одного из сертификатов

on_update:

- update command M_1

- update command M_N

Для каждого сертификата существует конфигурационный файл *.p12.cfg. Если кластер получает сертификат из SecMan, то в словаре pkcs12 будут описаны параметры доступа к сертификату на SecMan:

{

"pkcs12": {

"name": "", // Имя роли

"common_name": "", // CN для сертификата

"email": "", // Почтовый адрес владельца сертификата

"alt_names": "", // Альтернативные имена субъектов в списке, разделенном запятыми. Это могут быть имена хостов или адреса электронной почты

"ip_sans": "", // Альтернативные имена субъекта IP в списке с разделителями-запятыми. Действителен только в том случае, если роль разрешает IP SAN (по умолчанию)

"other_sans": "", // Настраиваемые SAN со строкой OID/UTF8

"exclude_cn_from_sans": "" // Параметр, включающий/выключающий возможность исключить common_name из DNS или электронной почты SAN

}

}

Если кластер использует локальный сертификат, то в словаре pkcs12 будет указан путь к локальному сертификату. Чтобы агент ротации мог обновить файл локального сертификата, необходимо в конфигурационном файле *.p12.cfg добавить словарь secman с описанием параметров доступа к сертификату на SecMan:

{

"secman": {

"name": "", // Имя роли

"common_name": "", // CN для сертификата

"email": "", // Почтовый адрес владельца сертификата

"alt_names": "", // Альтернативные имена субъектов в списке, разделенном запятыми. Это могут быть имена хостов или адреса электронной почты

"ip_sans": "", // Альтернативные имена субъекта IP в списке с разделителями-запятыми. Действителен только в том случае, если роль разрешает IP SAN (по умолчанию)

"other_sans": "", // Настраиваемые SAN со строкой OID/UTF8

"exclude_cn_from_sans": "" // Параметр, включающий/выключающий возможность исключить common_name из DNS или электронной почты SAN

}

}

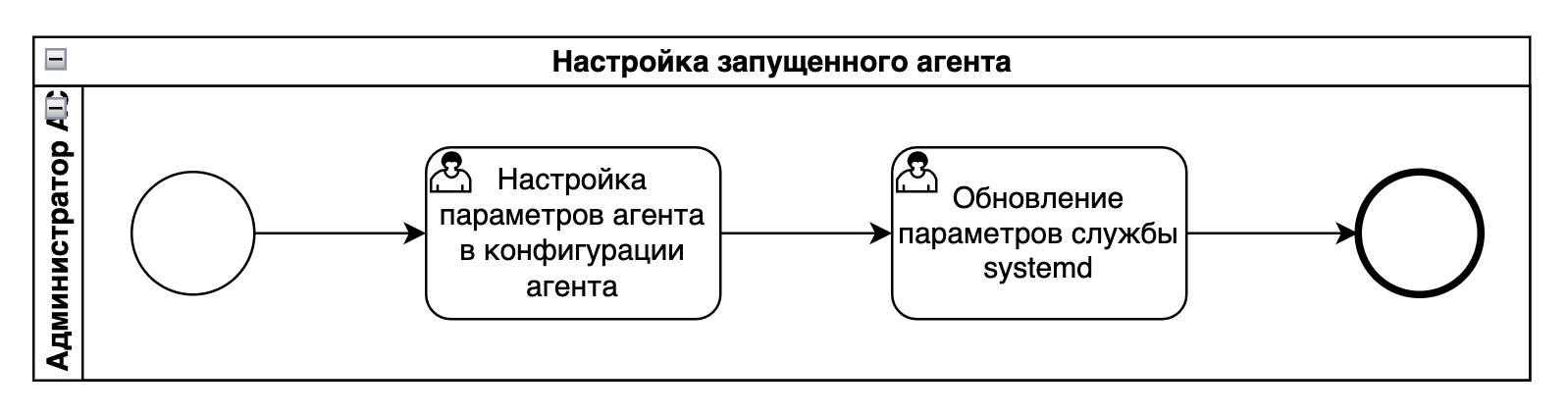

Настройка параметров запущенного агента

Примечание:

В случае кластерной конфигурации агент запускается на каждом из его узлов. Далее описывается настройка агента для standalone-конфигурации или при запуске на одном узле.

Чтобы изменить параметры запущенного агента, требуется обновить конфигурационный файл агента, который был указан в процессе инсталляции, и перезагрузить параметры службы pangolin-certs-rotate.service:

На первом шаге необходимо заполнить конфигурационный файл агента в формате YAML:

log:

directory: PATH/TO/LOG/DIRECTORY

filename: LOG_FILE_NAME

level: debug | info | warning | error | fatal

destination: console, file

certs:

enable_update: bool

poll_period_in_min: unsigned integer

retry_interval_in_sec: unsigned integer

retry_attempts_num: unsigned integer

watch:

- locations:

paths:

- PATH/TO/CERT/CONFIGURATION/1

- PATH/TO/CERT/CONFIGURATION/N

on_update:

- bash command 1

- bash command N

- locations:

paths:

- PATH/TO/CERT/CONFIGURATION/1

- PATH/TO/CERT/CONFIGURATION/M

on_update:

- bash command 1

- bash command M

Чтобы включить или отключить ротацию сертификатов, требуется установить значение ключа enable_update, который находится в yaml-словаре certs, в значение true или false соответственно.

Для изменения периода работы агента нужно задать новое значение ключа poll_period_in_min (в минутах), который тоже находится в словаре certs.

Для изменения времени ожидания с целью перезапуска агента (в случае ошибки) нужно задать новое значение ключа retry_interval_in_sec (в секундах). Ключ расположен в словаре certs.

Чтобы изменить количество повторных попыток в случае ошибки, нужно задать новое значение ключа retry_attempts_num, который находится в yaml-словаре certs.

Список сертификатов для обработки агентом задается в виде групп, определенных через ключ locations. Для каждой группы должна быть определена команда обновления сертификатов на кластере. Если один из сертификатов группы устаревает, обновляется на SecMan или появляется в списке отозванных, то выполняется команда, указанная по ключу on_update.

Далее приведен пример конфигурационного файла агента ротации сертификатов для конфигурации standalone-patroni-etcd-pgbouncer без контроля отозванных сертификатов:

certs:

enable_update: true

poll_period_in_min: 1440

retry_interval_in_sec: 60

retry_attempts_num: 1

watch:

- locations:

paths:

- "/home/postgres/ssl/server.p12.cfg"

- "/home/postgres/ssl/patroni.p12.cfg"

on_update:

- sudo systemctl reload pangolin-manager

- locations:

paths:

- "/home/postgres/ssl/server.p12.cfg"

- "/home/postgres/ssl/pgbouncer.p12.cfg"

on_update:

- sudo systemctl reload pangolin-pooler

При изменении имени конфигурационного файла агента требуется обновить параметры службы pangolin-certs-rotate.service. Имя файла указывается в качестве аргумента исполняемого файла /opt/pangolin-certs-rotate/bin/pangolin-certs-rotate:

ExecStart=/opt/pangolin-common/bin/pangolin-certs-rotate --config=/etc/pangolin-certs-rotate/pangolin-certs-rotate.yml

Для применения настроек необходимо перезагрузить службу:

sudo systemctl restart pg-certs-rotate_agent.service

Процесс обновления сертификатов на SecMan

При успешном подключении к SecMan, агент запрашивает каждый контролируемый сертификат отдельно, используя метод read. Метод fetch не используется, чтобы исключить автоматический перевыпуск сертификатов без их последующего обновления на кластере. Если интервал между датой истечения и датой выпуска сертификата достигает 80% внутри следующего периода (или если сертификат попал в список отозванных), то агент, используя метод generate, запрашивает его перевыпуск. Если в процессе обновления сертификата произошла ошибка, то следующая попытка откладывается на другую итерацию работы агента через период ожидания, определенный в конфигурационном файле.

Примечание:

Контроль за попаданием сертификатов в список отозванных реализуется в сервисе обновления CRL. Сервис ротации сертификатов сообщает сервису обновления CRL серийные номера используемых на кластере сертификатов. Если сервис обновления CRL находит сертификаты в списке отозванных, то сообщает об этом сервису ротации сертификатов, после чего запускается процесс их обновления на SecMan.

Процесс обновления сертификатов на кластере

При успешном обновлении на SecMan хотя бы одного сертификата из списка (или если обновление сертификатов на SecMan произошло без участия агента) агент запускает процесс обновления сертификатов на кластере. Для этой проверки он сохраняет серийные номера сертификатов, которые периодически сравнивает с полученными от SecMan.

Процесс обновления сертификатов на кластере состоит в перезагрузке параметров узла кластера или сервера конфигурации standalone с помощью команды, указанной в конфигурационном файле.

Внимание!

Агент не контролирует ошибки, которые могут произойти в процессе обновления сертификатов на кластере.

Отключению функциональности

Отключение производится путем удаления описанных выше конфигурационных параметров для соответствующих компонентов.

Поддержка CRL в компонентах кластера Pangolin

CRL представляет собой список сертификатов, которые УЦ пометил как отозванные (при этом сертификаты с истекшим сроком действия не вносятся в этот список). Каждая запись в списке включает идентификатор отозванного сертификата и дату отзыва. Дополнительная информация включает в себя ограничение по времени, если отзыв применяется в течение определенного периода времени, а также причину отзыва.

Функциональность доступна только для редакций Enterprise и Enterprise для ERP-систем.

Начиная с версии 5.4.0, использование файлов CRL поддерживается всеми компонентами кластера, а автоматическое обновление неактуальных файлов CRL доступно как часть функциональности агента ротации сертификатов pangolin-certs-rotate.

Настройка CRL

Для поддержки CRL имеются следующие параметры в конфигурационных файлах компонентов:

-

postgresql.conf(Pangolin):-

ssl_crl_file- путь к файлу CRL, по которому выполняется проверка статуса клиентских сертификатов; -

ssl_crl_dir- путь к директории с файлами CRL, по которым выполняется проверка аннулирования клиентских сертификатов.

Примечание:

При включенной защите параметров

ssl_crl_fileиssl_crl_dirинициализируются значениями из защищенного хранилища секретов. -

-

Клиентские утилиты, использующие библиотеку

libpq(psql):sslcrl(переменная окруженияPGSSLCRL) - путь к файлу CRL, по которому выполняется проверка статуса серверных сертификатов;sslcrldir(переменная окруженияPGSSLCRLDIR) - путь к директории с файлами CRL, по которым выполняется проверка статуса серверных сертификатов.

-

postgres.yml(Pangolin Manager):- в секции restapi:

crlfile- путь к файлу CRL;crlpath- путь к директории с файлами CRL, по которым выполняется проверка аннулирования клиентских сертификатов;

- в секции

postgresql/authentication/(replication/rewind/superuser):sslcrldir- путь к директории с файлами CRL, по которым выполняется проверка аннулирования серверного сертификата Pangolin;

- в секции

postgresql/parameters:sslcrldir- путь к каталогу с файлами CRL, по которым выполняется проверка аннулирования клиентских сертификатов;

- в секции restapi:

-

pangolin-pooler.ini(Pangolin Pooler):client_tls_crl_file- путь к файлу CRL;client_tls_crl_path- путь к директории с файлами CRL, по которым выполняется проверка аннулирования клиентских сертификатов;server_tls_crl_file- путь к файлу CRL;server_tls_crl_path- путь к директории с файлами CRL, по которым выполняется проверка аннулирования серверного сертификата Pangolin.

В параметрах конфигурации, приведенных выше, должны использоваться пути к существующим файлам CRL, иначе при включенном TLS/SSL запуск компонента завершится ошибкой.

Примечание:

Для использования директории c файлами CRL необходимо для каждого из файлов создать в этой директории символические ссылки, названные по хеш-значению от содержимого соответствующего файла CRL. Хеш-значения рассчитываются утилитой

c_rehash.Пример вызова утилиты:

c_rehash /pg_ssl/crlЗа подробностями обратитесь к документации OpenSSL.

Для обеспечения автоматического обновления файлов CRL расширяется функциональность агента ротации сертификатов pangolin-certs-rotate.

Запуск агента выполняется до запуска служб postgresql.service (для конфигурации standalone), pangolin-manager.service (для кластерной конфигурации) и pangolin-pooler.service, чтобы для каждого из компонентов выгрузить файлы CRL из CDP (CRL Distribution Point - точка распространения CRL). Компоненты кластера не запустятся, если файлы CRL прописаны в конфигурационных файлах, но отсутствуют на файловой системе. После выполнения первого цикла выгрузки CRL агент нотифицирует systemd о готовности в случае успешной выгрузки всех файлов CRL, иначе переводит статус службы в failed. Время цикла выгрузки CRL ограничено за счет установки времени ожидания в 30 сек на каждый запрос к CDP.

Примечание:

Агент не удаляет файлы CRL из файловой системы, только заменяет их на новые, поэтому исчезновение файлов CRL в процессе работы компонентов является результатом ручного вмешательства. Для восстановления удаленных файлов CRL перезапустите службу агента ротации и обновления CRL.

Исполняемый файл агента принимает в качестве аргумента командной строки путь к конфигурационному файлу агента pg_certs_rotate.yml, который расположен в директории /etc/postgres и включает следующие параметры:

- в секции log:

directory- путь к директории для лог-файлов (обязательный параметр при выводе лога в файл);filename- имя лог-файла (по умолчаниюpangolin-certs-rotate.log);level- (trace|debug|info|warning|error) - уровень логирования (по умолчаниюinfo);destination- методы записи лога (комбинируются через запятую):console- в стандартный поток вывода или ошибок (в случае запуска под управлением службы - в системный журнал). Значение по умолчанию;file- в файл.

- в секции crl:

enable_update(true|false) - включить/выключить автоматическое обновление CRL (по умолчаниюfalse);poll_period_in_min- интервал времени, определяющий период проверки наличия обновленных CRL файлов (задается как целое неотрицательное число в минутах; по умолчанию 60 минут; 0 для отключения периодической проверки CRL). Опрос CDP должен выполняться не реже данного периода;retry_interval_on_expire_in_sec- интервал повторных попыток выгрузки CRL, для которых дата публикации или дата окончания срока действия уже наступили (задается как целое положительное число в секундах, по умолчанию 30 секунд);retry_interval_on_failure_in_sec- интервал времени, через который выполняются повторные попытки выгрузки CRL после неудачи (задается как целое положительное число в секундах, по умолчанию 30 секунд);retry_attempts_num_on_failure- количество попыток выгрузки CRL по списку URI для данного пути расположения файла CRL после неудачи (по умолчанию 1 попытка);crl_file_perm- права доступа, устанавливаемые на выгружаемые файлы CRL (задается в восьмеричном формате, по умолчанию 0644).

- в секции watch:

locations- секция включает списки путей до файлов, обновление которых отслеживается (path), а также куда выгружаются новые CRL из CDP (uri):path- путь к файлу CRL;uri- массив URI для выгрузки CRL (основной и резервные);

on_update- список выполняемых команд, если файл CRL изменился (перечитывание конфигурации компонентами кластера).

Далее приведен формат конфигурационного файла агента ротации сертификатов и обновления CRL:

log:

directory: /pgerrorlogs/05/pangolin-certs-rotate

filename: pangolin-certs-rotate.log

level: info

destination: console,file

crl:

enable_update: false

poll_period_in_min: 60

retry_interval_on_expire_in_sec: 30

retry_interval_on_failure_in_sec: 30

retry_attempts_num_on_failure: 1

crl_file_perm: 0644

watch:

- locations:

- path: CRLPATH_1

uri:

- URI_1

- URI_N

- path: CRLPATH_N

uri:

- URI_1

- URI_N

on_update:

- sudo systemctl reload postgresql

- locations:

- path: CRLPATH_1

uri:

- URI_1

- URI_N

- path: CRLPATH_N

uri:

- URI_1

- URI_N

on_update:

- sudo systemctl reload pangolin-manager

- locations:

- path: CRLPATH_1

uri:

- URI_1

- URI_N

- path: CRLPATH_N

uri:

- URI_1

- URI_N

on_update:

- sudo systemctl reload pangolin-pooler

Справка по аргументам командной строки агента:

pangolin-certs-rotate --help

Allowed options:

-h [ --help ] produce this help message

-p [ --pid-file ] arg (=/var/run/pangolin-certs-rotate/pangolin-certs-rotate.pid)

path to agent's PID file

-c [ --config ] arg (=/etc/pangolin-certs-rotate/pangolin-certs-rotate.yml)

path to agent's configuration file

-d [ --dry-run ] check config file format and exit

Агент поддерживает режим пробного запуска с ключом --dry-run. В этом режиме проверяется корректность конфигурационного файла с последующим завершением выполнения. Результат проверки определяется кодом возврата: 0 - конфигурационный файл валидный, иначе 1. Информация об ошибке выводится в лог.

На старте агент сохраняет PID своего процесса в файл (по умолчанию /var/run/pangolin-certs-rotate/pangolin-certs-rotate.pid). Файл с PID процесса используется для предотвращения запуска еще одного экземпляра агента и в команде на ротацию лог-файла. Ротация лог-файлов агента выполняется с помощью утилиты logrotate. Файл конфигурации для logrotate расположен в /etc/logrotate.d/pangolin-certs-rotate и имеет следующее содержимое:

/pgerrorlogs/05/pangolin-certs-rotate/pangolin-certs-rotate.log {

rotate 10

dateext

daily

missingok

notifempty

compress

create 0640 postgres postgres

sharedscripts

postrotate

[ ! -f /var/run/pangolin-certs-rotate/pangolin-certs-rotate.pid ] || /bin/kill -USR1 `cat /var/run/pangolin-certs-rotate/pangolin-certs-rotate.pid 2> /dev/null` 2>/dev/null

endscript

}

Права доступа к директории с логами /pgerrorlogs/05/pangolin-certs-rotate:

drwxr-x--- 2 postgres postgres

Если включена автоматическая проверка обновления CRL (crl:enable_update), агент в установленное время подключается к первой доступной CDP по HTTP (crl:watch:locations:uri), выгружает файл CRL и сохраняет его в PEM-формате по пути, определенному в параметре crl:watch:locations:path (если файл CRL еще ни разу не выгружался или изменился в точке распространения).

Выгруженный файл CRL с истекшим сроком действия не сохраняется в файловой системе и не удаляется из нее.

Внимание!

Агент не проверяет подпись выгруженного файла CRL. Данную проверку выполняют компоненты кластера, для которых файл CRL предназначен.

Агент создает символическую ссылку на выгруженный файл CRL. Символическая ссылка именуется хеш-значением, рассчитанным по содержимому файла CRL. Если файл CRL до выгрузки нового уже существовал, то символическая ссылка на старый файл удаляется, чтобы не засорять файловую систему, поскольку хеш-значения от старого и нового файлов CRL будут отличаться. Символическая ссылка требуется, чтобы иметь возможность указывать директорию с файлами CRL в конфигурационных файлах компонентов кластера, так как OpenSSL выполняет поиск CRL по хеш-значению.

Если выгруженный файл CRL не является истекшим и не содержит серийные номера сертификатов, находящихся под контролем сервиса ротации сертификатов, агент выполнит команды перечитывания конфигурации соответствующих компонентов (crl:watch:locations:on_update). Если же файл CRL содержит серийные номера таких сертификатов, то соответствующие сертификаты будут перевыпущены сервисом ротации, а команды перечитывания конфигурации выполнятся после процедуры перевыпуска сертификатов.

Внимание!

Агент не контролирует ошибки, которые могут произойти в процессе перечитывания конфигурации компонентами кластера.

Для защиты файлов CRL от их перезаписи агентом в процедуре инициализации SSL контекста в компонентах кластера применяется блокировка на базе flock(). В процессе работы создается временный файл /tmp/.crl.lock. Агент удерживает для него эксклюзивную блокировку на время записи выгруженных CRL-файлов, тогда как компоненты кластера (на старте или при перечитывании параметров) используют для него разделяемую блокировку. Таким образом, компоненты кластера могут одновременно, не мешая друг другу, загружать файлы CRL, блокируясь только при обновлении файлов CRL агентом.

Для каждого файла CRL проверка обновления выполняется:

- при запуске агента;

- с периодичностью, определенной в параметре

crl:poll_period_in_min, если значение параметра больше 0; - в момент следующей публикации CRL (дата в поле CRL файла

NextCRLPublish) и через каждый интервал времени, определяемый параметромcrl:retry_interval_on_expire_in_sec(если после наступления даты публикации CRL еще не выпущен); - в момент истечения срока действия CRL (дата в поле CRL файла

NextUpdate) и через каждый интервал времени, определяемый параметромcrl:retry_interval_on_expire_in_sec, если после истечения срока действия CRL еще не выпущен; - спустя интервал времени, задаваемый параметром

crl:retry_interval_on_failure_in_sec, после неудачной выгрузки; - по требованию путем перезапуска службы агента (на его старте):

sudo systemctl restart pangolin-certs-rotate.service

-

при выполнении команды reload и изменении конфигурационного файла агента:

- изменился список URI;

- добавлена новая команда в

crl:watch:locations:on_update; - добавлен новый путь к файлу CRL.

sudo systemctl reload pangolin-certs-rotate.service

Примечание:

Дата следующей проверки обновления для каждого файла CRL рассчитывается индивидуально.

Процесс инсталляции

Пути к файлу CRL и директории, содержащей файлы CRL, задаются в конфигурационном файле инсталлятора и одинаковы для всех компонентов кластера. Ниже приведен формат его полей для настройки путей к файлам CRL:

pg_certs_pwd:

crl_file: "{{ '' | default('/pg_ssl/crl/root.crl', true) }}" # Путь к CRL файлу

crl_path: "{{ '' | default('/pg_ssl/crl', true) }}" # Путь к директории с файлами CRL

Для формирования конфигурационного файла агента и обновления CRL в конфигурационном файле инсталлятора необходимо добавить следующие параметры:

pangolin-certs-rotate:

enable: true # Настроить и запустить службу агента (не учитывается при обновлении агента, только при первичном развертывании)

agent_config: /etc/pangolin-certs-rotate/pangolin-certs-rotate.yml # Путь к конфигурационному файлу агента в формате YAML

update_agent_config: false # Обновить файл конфигурации агента (учитывается только при обновлении, значение по умолчанию - False)

log:

directory: /pgerrorlogs/05/pangolin-certs-rotate # Путь к директории для лог-файлов

filename: pangolin-certs-rotate.log # Имя лог-файла

level: info # Уровень логирования

destination: console,file # Методы записи лога

crl:

enable_update: false # Включить/выключить автоматическое обновление CRL

poll_period_in_min: 60 # Период проверки наличия обновленных CRL файлов

retry_interval_on_expire_in_sec: 30 # Тайм-аут для повторной попытки выгрузки CRL после наступления даты публикации CRL или окончания срока действия

retry_interval_on_failure_in_sec: 30 # Тайм-аут для повторной попытки выгрузки CRL после неудачи

retry_attempts_num_on_failure: 1 # Количество попыток выгрузки CRL по списку URI для данного пути расположения файла CRL после неудачи

crl_file_perm: 0644 # Права доступа, устанавливаемые на выгружаемые файлы CRL

watch:

- locations:

- path: path/to/crlfile_1 # Путь к обновляемому файлу CRL

uri:

- URI_1 # Основная точка распространения CRL

- URI_N # Резервная точка распространения CRL

- path: path/to/crlfile_N # Путь к обновляемому файлу CRL

uri:

- URI_1 # Основная точка распространения CRL

- URI_N # Резервная точка распространения CRL

on_update:

- sudo systemctl reload postgresql # Список выполняемых команд, если файл CRL изменился

Примечание:

Установка файлов агента на узел СУБД производится инсталлятором автоматически.

Обновление pangolin-certs-rotate осуществляется по одному из двух сценариев:

-

если агент был ранее установлен в обновляемой версии СУБД Pangolin (например, при переходе с версии СУБД Pangolin 5.4.0 на более высокую):

-

в зависимости от значения параметра

update_agent_config, который определяется в конфигурационном файле инсталлятора, автоматически настраивается файл конфигурации агента. По умолчанию значение параметра -False, в этом случае конфигурационный файл агента не заменяется версией конфигурации из файла инсталлятора. При необходимости ее обновления инсталлятором, параметр нужно установить в значениеTrue; -

в зависимости от состояния службы агента (

active/inactive) по окончании обновления версии СУБД служба агента будет либо запущена, либо нет. Проверить статус службы можно следующим способом:sudo systemctl status pangolin-certs-rotate | grep ActiveРезультат будет иметь следующий вид:

Active: active (running) since Tue 2023-05-23 15:59:02 MSK; 13s agoили

Active: inactive (dead)

-

-

если агент не был установлен в обновляемой версии СУБД Pangolin (например, при переходе с версии СУБД Pangolin 5.2.0):

- файл конфигурации агента создается и настраивается в соответствии с конфигурационным файлом инсталлятора (для незаполненных полей берутся значения по умолчанию);

- запуск службы агента в данном случае не производится.

Примечание:

В рамках механизма обновления версии СУБД скрипт-разведчик проверяет корректность заполнения файла конфигурации

pangolin-certs-rotate.

В файл /etc/sudoers вручную добавляются следующие команды, разрешенные пользователю postgres для выполнения без запроса пароля:

/bin/journalctl -f -u pangolin-certs-rotate

/usr/bin/systemctl start pangolin-certs-rotate

/usr/bin/systemctl stop pangolin-certs-rotate

/usr/bin/systemctl restart pangolin-certs-rotate

/usr/bin/systemctl reload pangolin-certs-rotate

/usr/bin/systemctl status pangolin-certs-rotate

/usr/bin/systemctl reload pangolin-manager

/usr/bin/systemctl reload postgres

В файл конфигурации службы pangolin-manager.service необходимо добавить команду reload:

ExecReload=/bin/kill -HUP $MAINPID

Мониторинг блокировок

Для оперативного мониторинга заблокированных объектов предусмотрен отдельный инструмент psql_lockmon.

Механизм отслеживания блокировок представляет собой набор представлений, позволяющий проводить оперативный мониторинг блокировок в разрезе:

- заблокированных объектов;

- типов блокировок;

- параметров сессии, которая заблокировала объект (при наличии прав);

- длительности сессий, запросов, ожидания блокировок, смены статуса (при наличии прав);

- текста последнего запроса в сессии (при наличии прав);

- дерева блокировок, при наличии очереди заблокированных объектов.

Поставка механизма отслеживания блокировок производится в виде расширения psql_lockmon.

Предусмотрена автоматизация развертывания решения на уровне специализированного сценария (custom.yml). Решение по умолчанию устанавливается в БД пользователя и в шаблонную БД.

Параметры управления легкими блокировками

Параметры позволяют управлять легкими блокировками (LWLock) на высоконагруженных системах для повышения производительности в следующих сценариях нагрузки:

- редкие пишущие запросы и чрезмерно частые читающие запросы;

- запросы с большим числом таблиц: партиционированные таблицы, таблицы с большим числом индексов, объединение таблиц с помощью оператора JOIN;

- запросы, сопровождающиеся частым обращением к буферному кешу для чтения страниц из файловой системы, записи страниц в файловую систему, вытеснения страниц из буферного кеша.

Функциональность доступна только для редакций Enterprise и Enterprise для ERP-систем.

Включение функциональности

Задание параметров осуществляется в конфигурационных файлах СУБД Pangolin (postgres.conf для standalone, postgres.yml для cluster), или в командной строке при запуске сервера. Список GUC-параметров управления легкими блокировками:

lwlock_shared_limit;fastpath_num_locks(deprecated);log2_num_lock_partitions;log2_num_buf_partitions;log2_fastpath_num_groups.

Примечание:

Параметр

fastpath_num_locksпродолжает существовать для обратной совместимости, но, начиная с версии СУБД Pangolin 7.1.0, он больше не влияет на поведение системы.После изменения параметра

lwlock_shared_limit, для применения значения, достаточно выполнить процесс перечитывания параметров СУБД Pangolin (reload). Изменениеlog2_num_lock_partitionsиlog2_num_buf_partitions,log2_fastpath_num_groupsтребует обязательного перезапуска сервера СУБД Pangolin (restart).

GUC-параметр lwlock_shared_limit

В СУБД Pangolin для работы с разделяемыми структурами данных, например с хеш-таблицей, используются легкие блокировки (LWLock). Имеются два режима: исключительный (для изменения данных, exclusive) и разделяемый (только для чтения, shared). Разделяемый режим позволяет одновременно многим процессам читать одни и те же данные, если в этот момент нет процессов, изменяющих эти данные. Как только пишущий процесс взял exclusive-блокировку, читающие процессы выстраиваются за ним в очередь. Если к моменту попытки получения exclusive-блокировки, удерживается shared-блокировка, то другие читающие процессы проходят вне очереди, продлевая время ожидания блокировки пишущих процессов.

Эта особенность очереди может привести к отказу в обслуживании при большом числе параллельно выполняющихся читающих запросов и редких пишущих. Пишущий процесс может надолго, если не вечно, зависнуть на захвате в исключительном режиме одной из легких блокировок транша LWLock:BufferMapping. Транш LWLock:BufferMapping состоит из 128 отдельных легких блокировок, каждая из которых защищает свою часть хеш-таблицы, позволяющей найти буфер в кеше по номеру блока в файловой системе. Интенсивная read-only нагрузка вытесняет из очереди пишущие процессы, которым требуется добавить в хеш-таблицу новый блок.

Для решения данной проблемы введен новый GUC-параметр lwlock_shared_limit. Параметр определяет количество последовательно запрашиваемых shared-блокировок, по достижении которого включается «честный» режим. В этом режиме запросы shared-блокировок становятся в очередь, а не получают блокировку немедленно, что позволяет избежать подавления exclusive-блокировок. Когда очередь доходит до exclusive-блокировки, процесс, владеющий этой блокировкой, отключает «честный» режим. При небольших значениях этого параметра exclusive-блокировки будут получаться гораздо быстрее, но могут возникнуть значительные издержки. С увеличением этого значения снижаются издержки, но уменьшается и ускорение. Имеет смысл использовать, если увеличение log2_num_lock_partitions не улучшает ситуации.

Диапазон значений: от 0 до 16383.

Значение по умолчанию: 0 («честный» режим отключен).

Рекомендуемое значение на высокой нагрузке: очень зависит от профиля нагрузки (в большинстве случаев можно использовать значение по умолчанию, в определенных ситуациях можно поднять до 10-20).

GUC-параметр log2_num_lock_partitions

При планировании и выполнении запросов устанавливаются тяжелые блокировки на объекты БД, участвующие в запросе, а по завершении транзакции эти блокировки снимаются. Информация о тяжелых блокировках хранится в хеш-таблице, расположенной в общей памяти сервера. Хеш-таблица менеджера блокировок поделена на 16 частей, доступ к каждой из которых защищен своей легкой блокировкой (транш LWLock:LockManager). На современных многоядерных системах с высокой степенью параллельности и большой нагрузкой 16 частей может оказаться недостаточно, если в запросе участвует более 16 объектов БД. В этом случае неизбежны коллизии: хеши, вычисленные по идентификаторам разных объектов БД, ссылаются на одну и ту же часть таблицы, что, в свою очередь, приводит к большой конкуренции за легкую блокировку, отвечающую за доступ к этой части хеш-таблицы. Поскольку захват блокировки осуществляется в исключительном режиме, коллизии хешей повышают вероятность ожидания процессов на событии LWLock:LockManager.

Для снижения влияния коллизий введен новый GUC-параметр log2_num_lock_partitions. Параметр позволяет настроить число частей, на которые будет поделена общая таблица блокировок, и, соответственно, количество легких блокировок в транше LWLock:LockManager. Значение параметра представляет степень, в которую нужно возвести число 2 (2^log2_num_lock_partitions), для получения фактического количества частей хеш-таблицы.

Увеличение количества секций относительно значения по умолчанию снижает конкуренцию при доступе к секциям структуры и может быть использовано при решении проблем с ожиданиями на LWLock:LockManager.

Диапазон значений: от 4 (16 частей) до 8 (256 частей)

Значение по умолчанию: 4 (16 частей).

Рекомендуемое значение на высокой нагрузке: 7.

GUC-параметр log2_num_buf_partitions

В СУБД Pangolin страницы отношений хранятся в буферном кеше. Он располагается в общей памяти сервера и доступен всем процессам. Когда менеджеру буферов требуется прочитать страницу, он сначала пытается найти ее в буферном кеше. Для быстрого поиска нужного буфера используется хеш-таблица Shared Buffer Lookup Table, хранящая номера буферов.

Для увеличения гранулярности хеш-таблица поделена на 128 частей (бакетов/корзин), доступ к каждой из которых защищается своей отдельной легкой блокировкой.

Эти легкие блокировки объединены в транш блокировок LWLock::BufferMapping для данной хеш-таблицы. Перед обращением к хеш-таблице процесс должен захватить легкую блокировку, на которую выпал ключ хеширования: идентификатор файла отношения, тип слоя и номер страницы внутри файла этого слоя. Блокировка захватывается в двух режимах: в разделяемом режиме - для чтения и в исключительном - для изменений.

В большинстве сценариев обращения к хеш-таблице происходят очень активно, поэтому эта блокировка становится "узким местом". На современных многоядерных системах число бакетов 128 оказывается недостаточным из-за высокой конкуренции за доступ к отдельному бакету.

Для решения описанной проблемы используйте GUC-параметр log2_num_buf_partitions для установки числа бакетов хеш-таблицы и, соответственно, количества легких блокировок в транше LWLock:BufferMapping. Увеличение значения параметра при интенсивной нагрузке позволит снизить вероятность ожидания процессов на событии LWLock:BufferMapping за счет увеличения гранулярности блокировок. Значение параметра представляет степень, в которую нужно возвести число 2, для получения фактического количества частей хеш-таблицы.

Диапазон значений: от 7 (128 частей) до 16 (65536 частей)

Значение по умолчанию: 7 (128 частей).

Рекомендуемое значение на высокой нагрузке: 10-12.

GUC-параметр log2_fastpath_num_groups

Для снижения нагрузки на разделяемую хеш-таблицу менеджера блокировок (LWLock:LockManager) применяется подход, называемый fast-path locking (блокировка объекта БД по быстрому пути). Fast-path-блокировка объекта БД возможна при выполнении следующих условий:

- блокировка захватывается на отношение (таблица, индекс, представление и пр.);

- запрашиваются менее конфликтующие режимы тяжелой блокировки, допускающие одновременное изменение данных в таблице (не конфликтуют между собой):

AccessShareLock,RowShareLock,RowExclusiveLock; - отсутствуют транзакции, заблокировавшие таблицу в более конфликтующем режиме: