citus. Добавление столбцового хранения и возможности организации распределенной OLAP БД

Версия: 13.0.1

В исходном дистрибутиве установлено по умолчанию: нет.

Связанные компоненты: отсутствуют.

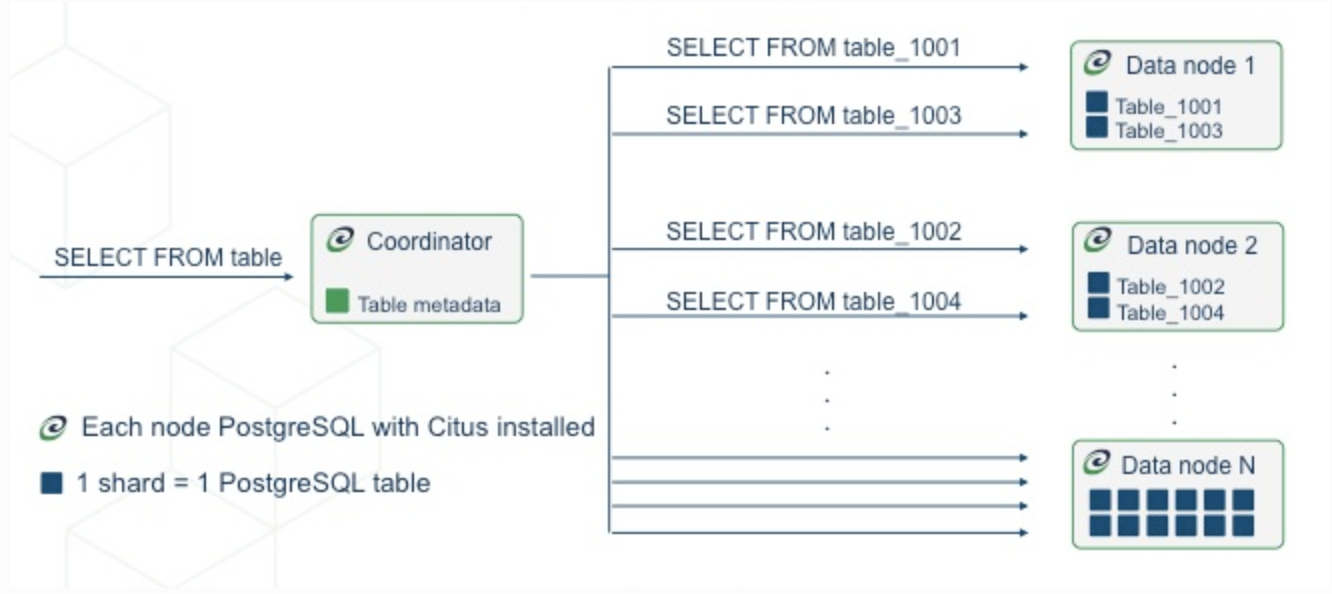

Схема размещения:

citus.В рамках данной задачи достигается совместимость свободно распространяемого расширения Citus с продуктом СУБД Pangolin. Необходимые доработки производятся в продукте Pangolin, расширение Citus тестируется на совместимость, как есть. В случае необходимости доработок их необходимо осуществлять через сообщество Citus.

Архитектура расширения

Термины и определения

Узлы

Citus - это расширение для PostgreSQL, которое позволяет обычным серверам баз данных (называемым узлами) взаимодействовать друг с другом в архитектуре “общего доступа”. Узлы образуют кластер, который позволяет PostgreSQL хранить больше данных и использовать больше процессорных ядер, чем это было бы возможно на одном компьютере. Эта архитектура также позволяет масштабировать базу данных, просто добавляя дополнительные узлы в кластер.

Узел-координатор и рабочие узлы

В каждом кластере есть один специальный узел, называемый координатором (остальные узлы называются рабочими). Приложения отправляют свои запросы на узел-координатор, который передает их соответствующим рабочим узлам и накапливает результаты. Для каждого запроса координатор либо направляет его на один рабочий узел, либо распараллеливает на несколько, в зависимости от того, хранятся ли требуемые данные на одном узле или на нескольких. Координатор знает, как это сделать, сверяясь со своими таблицами метаданных. В этих таблицах сохраняются DNS-имена и состояние рабочих узлов, а также распределение данных по узлам.

Сегментирование

Сегментирование - это метод, используемый в системах баз данных и распределенных вычислениях для горизонтального распределения данных по нескольким серверам или узлам. Он включает в себя разбиение большой базы данных или набора данных на более мелкие, более управляемые части, называемые сегментами. Каждый сегмент содержит подмножество данных, и вместе они образуют полный набор данных. Citus предлагает два типа сегментирования данных: на основе строк и на основе схем. Каждый вариант имеет свои собственные компромиссы в области сегментирования, позволяющие выбрать подход, который наилучшим образом соответствует требованиям приложения.

Сегментирование на основе строк

Традиционный способ сегментирования таблиц Citus в базе данных - это модель общей схемы, также известная как сегментирование на основе строк, при этом каждый узел содержит часть строк одной таблицы. Узел определяется путем столбца распределения, который позволяет разделить таблицу на строки. Это наиболее эффективный с точки зрения аппаратного обеспечения способ совместного использования. Клиенты плотно упакованы и распределены между узлами кластера. Однако при таком подходе необходимо убедиться, что все таблицы в схеме содержат столбец распределения и что все запросы в приложении фильтруются по нему. Сегментирование на основе строк отлично подходит для реализации, например, интернета вещей и позволяет добиться максимальной отдачи от использования оборудования.

Достоинства такого подхода:

- наилучшая производительность;

- наилучшая плотность пользователей на узел.

Недостатки:

- требует внесения изменений в схему;

- требует внесения изменений в запросы приложения;

- все клиенты должны использовать одну и ту же схему.

Сегментирование на основе схем

Доступное начиная с Citus 12.0 сегментирование на основе схем - это общая база данных, при этом схема становится логическим сегментом в базе данных. Мультитенантные приложения могут использовать схему для каждого клиента, что упрощает сегментирование по параметру клиента. Изменения запроса не требуются, и приложению обычно требуется лишь небольшая модификация для установки правильного пути поиска при переключении клиентов. Сегментирование на основе схем является идеальным решением для микросервисов и для интернет-провайдеров, развертывающих приложения, которые не могут подвергаться изменениям, необходимым для встроенного сегментирования на основе строк.

Достоинства:

- клиенты могут использовать разнородные схемы;

- модификация схемы не требуется;

- модификация запросов приложения не требуется;

- сегментирование на основе схемы обеспечивает лучшую совместимость с SQL по сравнению с сегментированием на основе строк.

Недостатки: меньшее количество арендаторов на узел по сравнению с сегментированием на основе строк

Особенности сегментирования разными способами

| Сегментирование на основе схем | Сегментирование на основе строк | |

|---|---|---|

| Мультитенантная модель | Отдельная схема на каждый тенант | Общая для всех тенантов таблица с распределением данных на основе уникального ключа |

| Поддерживаемая версия Citus | 12.0+ | Все версии |

| Дополнительные действия в PostgreSQL | Только изменение конфигурационных параметров | Изменение конфигурационных параметров, а также использование функции create_distributed_table для каждой таблицы и распределение по tenant ID(необходимо добавить ключ) |

| Количество тенантов | 1-10k | 1-1M+ |

| Требования к определению данных | Отсутствие внешних ключей между схемами | Необходимо добавление столбца tenant ID (столбец распределения, также называемый ключом сегментирования) в каждой таблице, в каждом первичном ключе и в каждом внешнем ключе |

| SQL требования к запросу на одном узле | Использование одной схемы в запросе | Joins и WHERE условия обязательно должны включать столбец с tenant_id(столбец распределения) |

| Параллельные кросс-тенантные запросы | Нет | Да |

| Собственные определения таблиц на тенантах | Да | Нет |

| Ролевая модель | Доступы в схеме | Доступы в схеме |

| Обмен данных между тенантами | Да, с использованием референсной таблицы(в отдельной схеме) | Да, с использованием референсной таблицы |

| Изоляция тенантов | У каждого тенанта есть своя собственная группа сегментов | Можно присвоить определенным идентификаторам тенантов их собственную группу сегмент с помощью функции isolate_tenant_to_new_shard |

Распределение данных

Существует 5 видов таблиц, каждый из которых используется для определенных задач.

Тип1: Распределенные таблицы

Первый тип, наиболее распространенный - это распределенные таблицы. Они выглядят как обычные таблицы для операторов SQL, но распределены по рабочим узлам горизонтально.

Здесь строки таблицы хранятся в таблицах table_1001, table_1002 и т.д. на рабочих узлах. Компоненты таблицы называются сегментами. Citus выполняет не только инструкции SQL, но и инструкции DDL в кластере, поэтому изменение схемы распределенной таблицы приводит к каскадному обновлению всех сегментов таблицы на узлах.

Столбец распределения

Citus использует алгоритмическое сегментирование для распределения строк по сегментам. Это означает, что назначение производится детерминистически – в данном случае на основе значения определенного столбца таблицы, называемого столбцом распределения. Администратор кластера должен назначить этот столбец при распределении таблицы. Правильный выбор важен для повышения производительности и функциональности, как описано в общем разделе о моделировании распределенных данных.

Тип 2: справочные(референсные) таблицы

Справочная таблица - это тип распределенной таблицы, все содержимое которой сосредоточено в одном сегменте, который реплицируется на каждом рабочем элементе. Таким образом, запросы на любом рабочем элементе могут получать доступ к справочной информации локально, без необходимости запрашивать строки из другого узла в сети. В справочных таблицах нет столбца распределения, поскольку нет необходимости выделять отдельные сегменты для каждой строки. Справочные таблицы обычно небольшие и используются для хранения данных, которые имеют отношение к запросам, выполняемым на любом рабочем узле. Например, перечисляемые значения, такие как статусы заказов или категории продуктов. При взаимодействии со справочной таблицей автоматически выполняется двухэтапная фиксация транзакций (2PC). Это означает, что Citus гарантирует, что данные всегда будут в согласованном состоянии, независимо от того, производится ли их запись, изменение или удаление.

Тип 3: локальные таблицы

При использовании Citus узел-координатор, к которому производится подключение, является обычной базой данных PostgreSQL с установленным расширением Citus. Таким образом, возможно создание обычных таблиц без предоставления к ним общего доступа. Это полезно для небольших административных таблиц, которые не участвуют в запросах объединения. Примером может служить таблица пользователей для входа в приложение и аутентификации. Создавать стандартные таблицы PostgreSQL легко, потому что они используются по умолчанию. При выполнении команды CREATE TABLE практически в каждом экземпляре Citus стандартные таблицы PostgreSQL сосуществуют с распределенными и справочными таблицами. Действительно, как упоминалось ранее, Citus сам использует локальные таблицы для хранения метаданных кластера.

Тип 4: локальные управляемые таблицы

Когда параметр citus.enable_local_reference_table_foreign_keys (boolean) включен, Citus может автоматически добавлять локальные таблицы в метаданные, если локальная таблица и справочная таблица связаны внешним ключом. Кроме того, эти таблицы можно создать вручную, выполнив функцию citus_add_local_table_to_metadata() для обычных локальных таблиц. Таблицы, представленные в метаданных, считаются управляемыми таблицами и могут быть запрошены с любого узла, Citus будет знать, как направить запрос координатору для получения данных из локальной управляемой таблицы. Такие таблицы отображаются как локальные в представлении таблиц Citus.

Тип 5: таблицы схем

При использовании сегментирования на основе схем, появившегося в Citus 12.0, распределенные схемы автоматически связываются с отдельными группами совместного размещения, так, что таблицы, созданные в этих схемах, автоматически преобразуются в распределенные таблицы без ключа сегмента. Такие таблицы считаются таблицами схемы и отображаются в виде схемы в представлении citus_tables.

Сегменты

В предыдущем разделе описывалось, как определяется подмножество строк распределенной таблицы в таблице меньшего размера внутри рабочего узла. В этом разделе более подробно рассматриваются технические детали. Таблица метаданных pg_dist_shared в координаторе содержит строку для каждого сегмента каждой распределенной таблицы в системе. Строка сопоставляет shardid с диапазоном целых чисел в хеш-пространстве (shardminvalue, shardmaxvalue):

SELECT * from pg_dist_shard;

logicalrelid | shardid | shardstorage | shardminvalue | shardmaxvalue

---------------+---------+--------------+---------------+---------------

github_events | 102026 | t | 268435456 | 402653183

github_events | 102027 | t | 402653184 | 536870911

github_events | 102028 | t | 536870912 | 671088639

github_events | 102029 | t | 671088640 | 805306367

(4 rows)

Если узел-координатор хочет определить, в каком сегменте содержится строка github_events, он хеширует значение столбца распределения в строке и проверяет, в каком диапазоне сегмента содержится хешированное значение. (Диапазоны определены таким образом, что хеш-функция представляет собой их непересекающееся объединение.)

Распределение сегментов

Предположим, что с указанной строкой связан сегмент 102027. Это означает, что строка должна быть прочитана или записана в таблицу с именем github_events_102027 на одном из рабочих узлов. Какой это узел? Это полностью определяется таблицами метаданных, а сопоставление сегмента с рабочим узлом называется размещением сегмента. Объединение таблиц метаданных дает ответ на данный вопрос. Координатор выполняет для маршрутизации запросов следующие действия: он делит запросы на фрагменты, которые ссылаются на конкретные таблицы, такие как github_events_102027, и запускает эти фрагменты в соответствующих рабочих системах.

SELECT

shardid,

node.nodename,

node.nodeport

FROM pg_dist_placement placement

JOIN pg_dist_node node

ON placement.groupid = node.groupid

AND node.noderole = 'primary'::noderole

WHERE shardid = 102027;

┌─────────┬───────────┬──────────┐

│ shardid │ nodename │ nodeport │

├─────────┼───────────┼──────────┤

│ 102027 │ localhost │ 5433 │

└─────────┴───────────┴──────────┘

В этом примере у таблицы github_events было четыре сегмента. Количество сегментов настраивается для каждой таблицы во время ее распределения по кластеру. Оптимальный выбор количества сегментов зависит от конкретного варианта использования.

Также обратите внимание на то, что Citus позволяет реплицировать сегменты для защиты от потери данных с помощью потоковой репликации PostgreSQL. Потоковая репликация позволяет создавать резервные копии каждого узла. Данный процесс прозрачен и не требует использования таблиц метаданных Citus.

Совместное расположение

Поскольку сегменты могут быть размещены на узлах как угодно, имеет смысл размещать сегменты, содержащие связанные строки связанных таблиц на одних и тех же узлах. Таким образом, запросы объединения таких данных позволяют избежать отправки большого количества информации по сети и могут выполняться внутри одного узла Citus. В качестве примера можно привести базу данных с магазинами, продуктами и покупками. Если все три таблицы содержат столбец store_id и распределяются по нему, то все запросы, ограниченные одним магазином, могут эффективно выполняться на одном рабочем узле. Это верно всегда, запросы могут включать любую комбинацию этих таблиц.

Параллелизм

Распределение запросов по нескольким компьютерам позволяет выполнять больше запросов одновременно и позволяет увеличить скорость обработки за счет добавления новых компьютеров в кластер. Кроме того, разбиение одного запроса на фрагменты, как описано в предыдущих разделах, повышает вычислительную мощность. В последнем случае достигается наиболее оптимальное распараллеливание. Запросы, считывающие сегменты или влияющие на них, равномерно распределенные по многим узлам, могут выполняться в реальном времени. Обратите внимание, что результаты запроса по-прежнему должны передаваться обратно через узел-координатор, поэтому ускорение наиболее заметно, когда конечные результаты являются компактными, например, при использовании агрегированных функций, таких как подсчет и описательная статистика.

Выполнение запросов

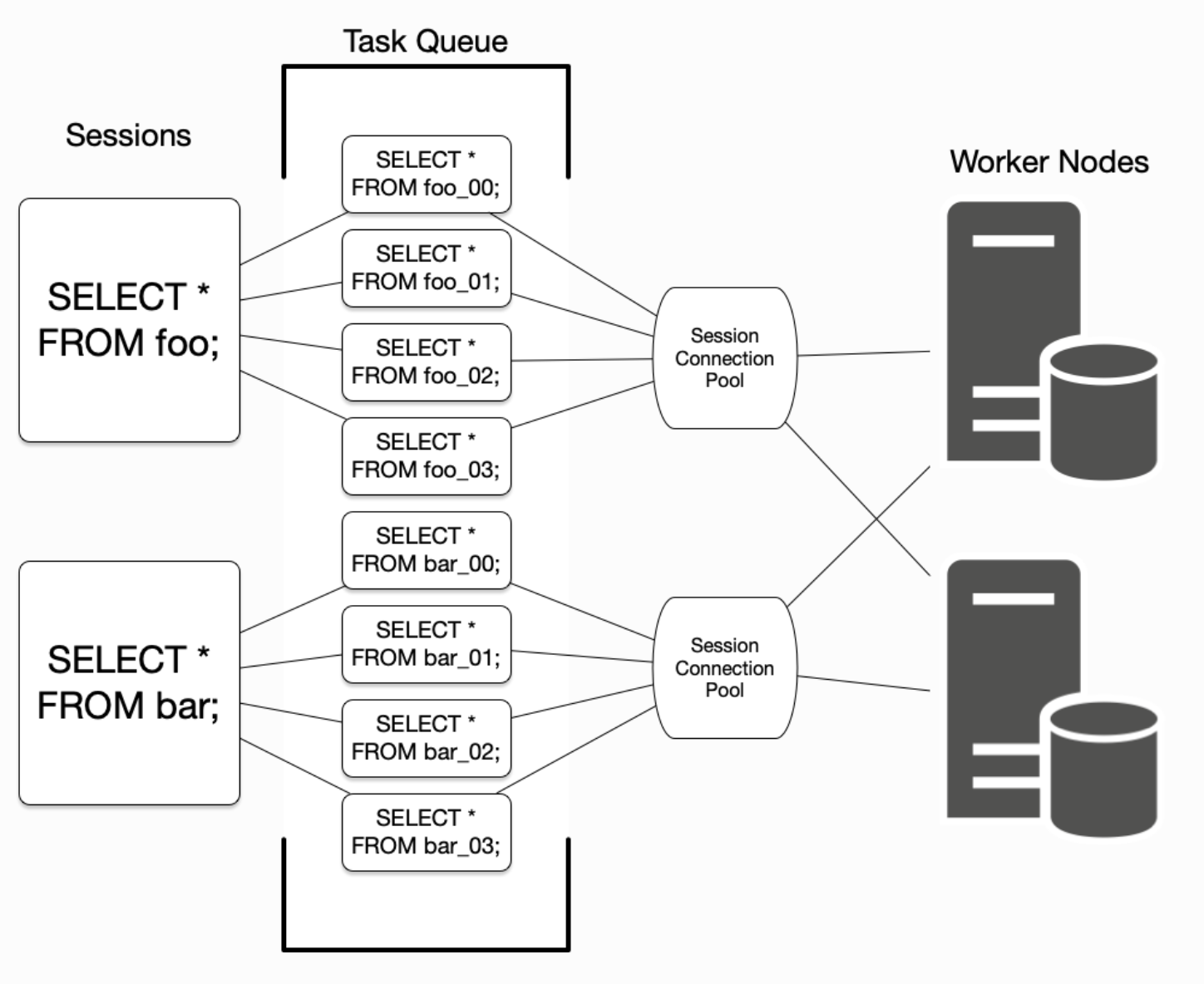

При выполнении запросов с несколькими сегментами Citus должен балансировать между выгодой от параллелизма с издержками, связанными с подключениями к базе данных (задержка сети и использование ресурсов рабочего узла). Чтобы настроить выполнение запросов Citus для достижения наилучших результатов для конкретного профиля нагрузки на базу данных, полезно понять, как Citus управляет подключениями к базе данных между узлом-координатором и рабочими узлами и сохраняет их. Citus преобразует каждый входящий запрос с несколькими сегментами в запросы для каждого сегмента, называемые задачами. Он ставит задачи в очередь и запускает их, как только удается установить соединение с соответствующим рабочим узлом. Для запросов к распределенным таблицам foo и bar приведена схема управления подключениями:

Узел-координатор удерживает пул подключений для каждой сессии. Каждый запрос (например, SELECT * FROM foo на диаграмме) ограничен открытием не более чем citus.max_adaptive_executor_pool_size(integer) одновременных подключений для каждого рабочего узла. Этот параметр настраивается на уровне сеанса для управления приоритетами.

Предполагается, что короткие задачи быстрее выполнять последовательно по одному и тому же соединению, чем устанавливать для них новые соединения параллельно. С другой стороны, для длительно выполняемых задач преимущество заключается в большем распараллеливании.

Для оптимизации коротких и длительных задачах, Citus опирается на параметр citus.executor_slow_start_interval (integer). Этот параметр определяет задержку между попытками подключения для задач в многосегментном запросе. Когда запрос сначала ставит задачи в очередь, они могут подключаться только к одному соединению. В конце каждого интервала, когда есть ожидающие подключения, Citus увеличивает количество одновременно открываемых подключений. Режим медленного запуска можно полностью отключить, установив значение параметра равным 0.

Когда задача завершается, соединение в пуле остается открытым для последующего использования. Кеширование соединения позволяет избежать затрат на восстановление соединения между координатором и рабочим узлом. Однако каждый пул будет содержать не более citus.max_cached_conns_per_worker(integer) свободных подключений, открытых одновременно, чтобы ограничить использование ресурсов ненужными соединениями на рабочем узле.

Наконец, параметр citus.max_shared_pool_size(integer) ограничивает общее количество подключений на один рабочий узел.

Описание функций

Команды DDL для управления таблицами и сегментами

citus_schema_distribute(schemaname regnamespace) returns void

Позволяет преобразовать существующие обычные схемы в распределенные схемы, которые автоматически связываются с отдельными группами совместного размещения, так что таблицы, созданные в этих схемах, будут автоматически преобразованы в совместно размещенные распределенные таблицы без ключа сегмента. В процессе распространения схемы она будет автоматически назначена и перемещена на существующий узел в кластере. В качестве аргумента данная функция принимает имя схемы, которую необходимо распределить.

Пример использования:

SELECT citus_schema_distribute('tenant_a');

SELECT citus_schema_distribute('tenant_b');

SELECT citus_schema_distribute('tenant_c');

citus_schema_undistribute(schemaname regnamespace) returns void

Преобразует существующую распределенную схему обратно в обычную схему. В результате этого процесса таблицы и данные перемещаются с текущего узла обратно на узел-координатор в кластере. В качестве аргумента принимает имя схемы, распределение для которой необходимо отменить.

Пример использования:

SELECT citus_schema_undistribute('tenant_a');

SELECT citus_schema_undistribute('tenant_b');

SELECT citus_schema_undistribute('tenant_c');

create_distributed_table (table_name regclass, distribution_column text, distribution_type citus.distribution_type, [ colocate_with text ], [ shard_count int ]) returns void

Используется для определения распределенной таблицы и создания ее фрагментов, если это таблица с распределенным хешем. Эта функция принимает в качестве аргументов:

- имя таблицы;

- столбец распределения;

- метод распределения (необязательный параметр) - данный параметр включает текущую таблицу в группу совместного размещения другой таблицы. По умолчанию таблицы размещаются совместно, если они распределены по столбцам одного типа с одинаковым количеством сегментов. В случае необходимости изменить это распределение позже, возможно использовать функцию

update_distributed_table_colocation. Возможными значениями дляcolocate_withявляютсяdefault, none для создания новой группы совместного размещения или имя другой таблицы для совместного размещения с этой таблицей (см. раздел совместное расположение таблиц). Имейте в виду, что значениеcolocate_withпо умолчанию подразумевает совместное расположение. Как поясняется в описании совместного расположения таблиц, это может быть полезно, когда таблицы связаны или будут объединены. Однако, когда две таблицы не связаны между собой, но случайно используют один и тот же тип данных для своих распределенных столбцов, их случайное совместное расположение может снизить производительность при ребалансировке сегментов. Сегменты таких таблиц будут перемещены совместно без необходимости указания директивы cascade. Если необходимо изменить это неявное поведение, возможно воспользоваться функциейupdate_distributed_table_colocation. Если новая распределенная таблица не связана с другими таблицами, лучше всего указатьcolocate_with => 'none'; - количество сегментов (необязательный параметр) - определяет количество сегментов, которые нужно создать для новой распределенной таблицы. При указании этого параметра нельзя указать значение

colocate_with, отличное отnone. Чтобы изменить количество сегментов в существующей таблице или группе совместного размещения (co-location group), используйте функциюalter_distributed_table. Возможные значения для параметраshard_countнаходятся в диапазоне от1до64000. Рекомендации по выбору оптимального значения приведены в разделе Количество сегментов.

В результате работы функция вставляет соответствующие метаданные, чтобы пометить таблицу как распределенную. Функция по умолчанию использует распределение по хешу, если метод распределения не указан. Если таблица распределена по хешу, функция также создает рабочие сегменты на основе значения конфигурации количества сегментов. Если таблица содержит какие-либо строки, они автоматически распределяются по рабочим узлам.

Пример использования:

SELECT create_distributed_table('github_events', 'repo_id');

-- alternatively, to be more explicit:

SELECT create_distributed_table('github_events', 'repo_id',

colocate_with => 'github_repo');

В этом примере таблица github_events будет распределена по хешу в столбце repo_id.

truncate_local_data_after_distributing_table (function_name regclass) returns void

Выполняет усечение всех локальных строк после распространения таблицы и предотвращает сбои из-за устаревших локальных записей. Усечение выполняется каскадно для таблиц, имеющих внешний ключ к указанной таблице. Если ссылающиеся таблицы сами по себе не распространяются, то усечение запрещено до тех пор, пока они не будут распространены, чтобы защитить целостность ссылок. При попытке выполнить такое усечение возникнет ошибка:

ERROR: cannot truncate a table referenced in a foreign key constraint by a local table

Усечение данных таблицы узлов локального координатора безопасно для распределенных таблиц, поскольку их строки, если таковые имеются, копируются на рабочие узлы во время распространения. В качестве аргумента функция принимает имя таблицы для усечения. Пример использования:

-- requires that argument is a distributed table

SELECT truncate_local_data_after_distributing_table('public.github_events');

undistribute_table (table_name regclass, cascade_via_foreign_keys boolean) returns void

Отменяет действие create_distributed_table или create_reference_table. Функция перемещает все данные из сегментов обратно в локальную таблицу на узле-координаторе (при условии, что данные могут поместиться), а затем удаляет сегменты. Citus не будет отменять распространение таблиц, которые содержат внешние ключи или на которые ссылаются внешние ключи, если только аргументу cascade_via_foreign_keys не присвоено значение true. Если этот аргумент имеет значение false (или опущен), то необходимо вручную удалить нарушающие ограничения внешнего ключа перед отменой распространения. В качестве аргументов функция принимает имя таблицы, распределение которой необходимо отменить, а также необязательный параметр cascade_via_foreign_keys. Если для этого параметра установлено значение true, функция также отменяет распределение всех таблиц, связанных с table_name через внешние ключи. Необходимо осторожно относиться к этому параметру, поскольку он потенциально может повлиять на многие таблицы.

Пример использования:

-- first distribute the table

SELECT create_distributed_table('github_events', 'repo_id');

-- undo that and make it local again

SELECT undistribute_table('github_events');

alter_distributed_table (table_name regclass, distribution_column text, shard_count int, colocate_with text, cascade_to_colocated boolean) returns void

Изменяет столбец распределения, количество сегментов или свойства расположения в распределенной таблице. В качестве аргументов принимает имя таблицы, столбец распределения(необязательный параметр), количество сегментов(необязательный параметр), таблицу для совмещения(см. параметр colocate_with функции create_distributed_table) и необязательный параметр cascade_to_colocated. Когда этому аргументу присвоено значение true, изменения shard_count и colocate_with также будут применены ко всем таблицам, которые ранее были размещены совместно с изменяемой таблицей, и расположение будет сохранено. Если оно равно false, текущее размещение этой таблицы будет нарушено. Пример использования:

-- change distribution column

SELECT alter_distributed_table('github_events', distribution_column:='event_id');

-- change shard count of all tables in colocation group

SELECT alter_distributed_table('github_events', shard_count:=6, cascade_to_colocated:=true);

-- change colocation

SELECT alter_distributed_table('github_events', colocate_with:='another_table');

alter_table_set_access_method (table_name regclass, access_method text) returns void

Изменяет метод хранения(heap или columnar). В качестве аргументов принимает имя таблицы и метод доступа.

Пример использования:

SELECT alter_table_set_access_method('github_events', 'columnar');

remove_local_tables_from_metadata() returns void

Удаляет локальные таблицы из метаданных Citus, если они больше не должны там находиться. (См. параметр citus.enable_local_reference_table_foreign_keys(boolean) )

Обычно, если локальная таблица находится в метаданных Citus, на это есть причина, например, наличие внешних ключей между таблицей и справочной таблицей. Однако, если параметр enable_local_reference_foreign_keys отключен, Citus больше не будет управлять метаданными в этой ситуации, и ненужные метаданные могут сохраняться до тех пор, пока они не будут удалены вручную.

Пример использования:

SELECT remove_local_tables_from_metadata();

create_reference_table (table_name regclass) returns void

Используется для определения небольшой справочной таблицы или таблицы измерений. Принимает в качестве аргумента имя таблицы и создает распределенную таблицу всего с одним сегментом, реплицируемую на каждый рабочий узел.

Пример использования:

SELECT create_reference_table('nation');

citus_add_local_table_to_metadata (table_name regclass, cascade_via_foreign_keys boolean) returns void

Добавляет локальную таблицу PostgreSQL в метаданные Citus. Основным вариантом использования этой функции является обеспечение доступа к локальным таблицам в координаторе с любого узла кластера. В основном это полезно при выполнении запросов с других узлов. Данные, связанные с локальной таблицей, остаются в координаторе – рабочим элементам отправляются только их схема и метаданные. Обратите внимание, что добавление локальных таблиц к метаданным сопряжено с небольшими затратами. При добавлении таблицы Citus должен отслеживать ее в таблице разделов. Локальные таблицы, добавляемые в метаданные, наследуют те же ограничения, что и справочные таблицы. Если используется undistributed_table, Citus автоматически удалит результирующие локальные таблицы из метаданных, что устранит такие ограничения для этих таблиц.

В качестве аргументов функция принимает имя таблицы на координаторе для распространения, а также параметр cascade_via_foreign_keys. Если для этого параметра установлено значение true, функция автоматически добавляет в метаданные другие таблицы, которые связаны внешним ключом с данной таблицей. Будьте осторожны с этим параметром, поскольку он потенциально может повлиять на многие таблицы.

Пример использования:

SELECT citus_add_local_table_to_metadata('nation');

update_distributed_table_colocation (table_name regclass, colocate_with text) returns void

Используется для обновления параметров совместного размещения распределенной таблицы. Эта функция также может использоваться для отмены совместного размещения распределенной таблицы. Citus неявно объединит две таблицы, если столбец распределения имеет один и тот же тип, это может быть полезно, если таблицы связаны и будут выполняться запросы с объединением этих таблиц. Если таблицы A и B будут объединены, и таблица A будет ребалансирована, таблица B также будет ребалансирована. Если таблица B не имеет идентификатора реплики, балансировка не будет выполнена. Следовательно, в этом случае эта функция может быть полезна для устранения неявного совместного размещения. Обратите внимание, что эта функция не перемещает какие-либо данные физически. В качестве аргументов принимается имя таблицы, параметры совместного размещения для которой необходимо обновить, а также имя таблицы, к которой должна быть выполнена привязка. Если необходимо совсем отменить привязку таблицы, следует указать colocate_with => 'no'.

Пример использования:

-

В этом примере показано, что расположение таблицы

Aобновляется как расположение таблицыB:SELECT update_distributed_table_colocation('A', colocate_with => 'B'); -

Предположим, что таблицы

AиBрасположены совместно (возможно, неявно), если необходимо нарушить их расположение:SELECT update_distributed_table_colocation('A', colocate_with => 'none'); -

Теперь предположим, что таблица

A, таблицаB, таблицаCи таблицаDрасположены вместе, и необходимо разместить их по парам - таблицуAи таблицуBвместе, а также таблицуCи таблицуD- вместе:SELECT update_distributed_table_colocation('C', colocate_with => 'none');

SELECT update_distributed_table_colocation('D', colocate_with => 'C'); -

Если есть распределенная по хешу таблица с методом распределения none и необходимо обновить ее расположение, нужно сделать следующее:

SELECT update_distributed_table_colocation('"none"', colocate_with => 'some_other_hash_distributed_table');

create_distributed_function (function_name regprocedure, [ distribution_arg_name text ], [ colocate_with text ]) returns void

Передает функцию от узла-координатора рабочим узлам и помечает ее для распределенного выполнения. Когда на координаторе вызывается распределенная функция, Citus использует значение “аргумента распределения”, чтобы выбрать рабочий узел для выполнения функции. Выполнение функции на рабочих устройствах увеличивает параллелизм и может приблизить код к данным в сегментах для снижения задержек. Обратите внимание, что путь поиска(search_path) в PostgreSQL не передается от координатора к рабочим узлам во время выполнения распределенной функции, поэтому код распределенной функции должен полностью определять имена объектов базы данных. Также уведомления, отправляемые функциями, не будут отображаться пользователю. В качестве аргументов принимаются:

- Имя функции, которая будет распространяться. В скобках должны быть указаны типы параметров функции, поскольку в PostgreSQL несколько функций могут иметь одинаковые имена. Например,

foo(int)отличается отfoo(int, text). - Имя аргумента, по которому будет осуществляться распределение(необязательный параметр). Для удобства (или если у аргументов функции нет имен) допускается использование позиционного заполнителя, такого как

$1. Если этот параметр не указан, то функция с именемfunction_nameпросто создается на рабочих узлах. Если в будущем будут добавлены рабочие узлы, функция будет автоматически создана и там. - Имя таблицы для совместного размещения(необязательный параметр). Когда распределенная функция выполняет чтение или запись в распределенную таблицу (или, в более общем случае, в совместно размещаемые таблицы), обязательно присваивайте имя этой таблицы, используя параметр

colocate_with. Это гарантирует, что каждый вызов функции выполняется на рабочем узле, содержащем соответствующие сегменты.

Пример использования:

-- an example function which updates a hypothetical

-- event_responses table which itself is distributed by event_id

CREATE OR REPLACE FUNCTION

register_for_event(p_event_id int, p_user_id int)

RETURNS void LANGUAGE plpgsql AS $fn$

BEGIN

INSERT INTO event_responses VALUES ($1, $2, 'yes')

ON CONFLICT (event_id, user_id)

DO UPDATE SET response = EXCLUDED.response;

END;

$fn$;

-- distribute the function to workers, using the p_event_id argument

-- to determine which shard each invocation affects, and explicitly

-- colocating with event_responses which the function updates

SELECT create_distributed_function(

'register_for_event(int, int)', 'p_event_id',

colocate_with := 'event_responses'

);

alter_columnar_table_set (table_name regclass, chunk_group_row_limit int, stripe_row_limit int, compression name, compression_level int) returns void

Изменяет настройки таблицы с колоночным типом хранения. При вызове этой функции для таблицы, не содержащей столбцов, возникает ошибка. Все аргументы, кроме имени таблицы, являются необязательными. Чтобы просмотреть текущие параметры для всех колоночных таблиц, обратитесь к таблице columnar.options

Значения по умолчанию для вновь создаваемых колоночных таблиц могут быть переопределены с помощью параметров:

columnar.compression;columnar.compression_level;columnar.stripe_row_count;columnar.chunk_row_count.

На вход функция принимает следующие аргументы:

table_name: Имя столбчатой таблицы;chunk_row_count: (необязательно) Максимальное количество строк в блоке для вновь вставляемых данных. Существующие блоки данных не будут изменены и могут содержать больше строк, чем это максимальное значение. Значение по умолчанию -10000;stripe_row_count: (необязательно) Максимальное количество строк в строке для вновь вставляемых данных. Существующие строки данных не будут изменены и могут содержать больше строк, чем это максимальное значение. Значение по умолчанию равно150000;compression: (необязательно) Возможные значения:[none|pglz|zstd|lz4|lz4hc]. Тип сжатия для вновь вставляемых данных. Существующие данные не будут сжаты или распакованы. Стандартным и обычно рекомендуемым значением являетсяzstd(если поддержка была заявлена при компиляции);compression_level: (необязательно) Допустимые значения - от1до19. Если метод сжатия не поддерживает выбранный уровень, вместо него будет выбран ближайший уровень.

Пример использования:

SELECT alter_columnar_table_set(

'my_columnar_table',

compression => 'none',

stripe_row_count => 10000);

create_time_partitions (table_name regclass, partition_interval interval, end_at timestamptz, start_from timestamptz) returns boolean

Создает разделы с заданным интервалом, чтобы охватить заданный диапазон времени. Входные аргументы:

table_name: таблица (regclass), для которой необходимо создать новые разделы. Таблица должна быть разделена на один столбец типаdate,timestampилиtimestamptz;partition_interval: интервал времени, например2 hoursили1 month, который используется при настройке диапазонов для новых разделов;end_at: (timestamptz) создаст разделы до этого времени. Последний раздел будет содержать точкуend_at, и последующие разделы созданы не будут;start_from: (timestamptz, необязательный параметр) - выберет первый раздел так, чтобы он содержал точкуstart_from. Значение по умолчанию -now().

Функция вернет True, если требовалось создать новые разделы, и False, если все они уже существовали.

Пример использования:

-- create a year's worth of monthly partitions

-- in table foo, starting from the current time

SELECT create_time_partitions(

table_name := 'foo',

partition_interval := '1 month',

end_at := now() + '12 months'

);

drop_old_time_partitions (table_name regclass, older_than timestamptz)

Удаляет все разделы, интервалы между которыми приходятся на заданную временную метку. В дополнение к использованию этой функции можно рассмотреть использование функции alter_old_partitions_set_access_method для сжатия старых разделов с помощью колоночного хранилища. В качестве аргументов принимается:

table_name- имя таблицы, для которой необходимо удалить разделы. Таблица должна быть разделена по одному столбцу типаdate,timestampилиtimestamptz;older_than(timestamptz)- функция удалит разделы, верхний диапазон которых меньше или равен аргументуolder_than.

Пример использования:

-- drop partitions that are over a year old

CALL drop_old_time_partitions('foo', now() - interval '12 months');

alter_old_partitions_set_access_method (parent_table_name regclass, older_than timestamptz, new_access_method name)

В случае использования данных временных рядов таблицы часто разбиваются на разделы по времени, а метод хранения старых разделов меняется на колоночное хранилище, доступное только для чтения, для лучшего сжатия. На вход принимаются аргументы:

parent_table_name: таблица (regclass), для которой требуется изменить разделы. Таблица должна быть разделена по одному столбцу типаdate,timestampилиtimestamptz;older_than: функция изменит разделы, верхний диапазон которых старше или равен значению, переданному в этом аргументе;new_access_method: либоheapдля хранилища на основе строк, либоcolumnarдля колоночного хранилища.

Пример использования:

CALL alter_old_partitions_set_access_method(

'foo', now() - interval '6 months',

'columnar'

);

Конфигурационная информация и метаданные

citus_add_node(nodename text, nodeport integer, groupid integer, noderole noderole, nodecluster name) returns integer

Для работы функции требуются права суперпользователя.

Функция citus_add_node() регистрирует добавление нового узла в кластер в таблице метаданных pg_dist_node. Она также копирует справочные таблицы на добавляемый узел.

При запуске citus_add_node() в кластере с одним узлом, убедитесь, что предварительно была запущена функция citus_set_coordinator_host().

Функция принимает следующие аргументы:

nodename: DNS-имя или IP-адрес нового добавляемого узла;nodeport: порт PostgreSQL на рабочем узле;groupid: Группа из одного основного сервера и дочерних серверов, соответствующая только потоковой репликации. Обязательно установите дляgroupidзначение, большее нуля, поскольку ноль зарезервирован для узла-координатора. Значение по умолчанию равно-1;noderole: является ли он «основным»(primary) или «вторичным»(secondary). Значение по умолчанию -primary;nodecluster: Имя кластера. По умолчанию -default.

В результате работы функция вернет значение nodeid для добавленной в таблицу pg_dist_node строки.

Пример использования:

select * from citus_add_node('new-node', 12345);

citus_add_node

-----------------

7

(1 row)

citus_update_node (node_id int, new_node_name text, new_node_port int, force bool, lock_cooldown int) returns void

Для работы функции требуются права суперпользователя.

Функция citus_update_node() изменяет имя хоста и порт для узла, зарегистрированного в таблице метаданных citus.pg_dist_node. В качестве аргументов на вход функции передаются значение nodeid из таблицы pg_dist_node для сервера, параметры которого изменяются, dns-имя или адрес узла и порт для подключения.

Пример использования:

select * from citus_update_node(123, 'new-address', 5432);

citus_set_node_property (nodename text, nodeport integer, property text, value boolean) returns void

Функция citus_set_node_property() изменяет свойства в таблице метаданных Citus pg_dist_node. В настоящее время она может изменять только свойство shouldhaveshards. На вход принимаются dns-имя или IP-адрес узла, свойства которого меняются, порт для подключения к PostgreSQL, имя свойства в pg_dist_node (в настоящий момент поддерживается только shouldhaveshards) и значение параметра(true или false).

Пример использования:

SELECT * FROM citus_set_node_property('localhost', 5433, 'shouldhaveshards', false);

citus_add_inactive_node (nodename text, nodeport integer, groupid integer, noderole noderole, nodecluster name) returns integer

Для работы функции требуются права суперпользователя.

Функция citus_add_inactive_node() регистрирует добавление нового узла в кластер в таблице метаданных citus.pg_dist_node аналогично тому, как это делает функция citus_add_node, но в отличие от нее данная функция помечает рабочий узел как неактивный, что подразумевает, что на нем не могут быть размещены никакие сегменты. Также не копируются справочные таблицы на добавляемый узел.

Функция принимает следующие аргументы:

nodename: DNS-имя или IP-адрес нового добавляемого узла;nodeport: порт PostgreSQL на рабочем узле;groupid: Группа из одного основного сервера и дочерних серверов, соответствующая только потоковой репликации. Обязательно установите дляgroupidзначение, большее нуля, поскольку ноль зарезервирован для узла-координатора. Значение по умолчанию равно-1;noderole: является ли он «основным»(primary) или «вторичным»(secondary). Значение по умолчанию -primary;nodecluster: Имя кластера. По умолчанию -default.

В результате работы функция вернет значение nodeid для добавленной в таблицу pg_dist_node строки.

Пример использования:

select * from citus_add_inactive_node('new-node', 12345);

citus_add_inactive_node

--------------------------

7

(1 row)

citus_activate_node (nodename text, nodeport integer) returns integer

Для работы функции требуются права суперпользователя.

Помечает рабочий узел как активный в таблице pg_dist_node. Также копирует справочные таблицы на данный узел. На вход функция принимает dns-имя и порт подключения к PostgreSQL для рабочего узла.

В результате работы функция вернет значение nodeid для измененной в таблице pg_dist_node строки.

Пример использования:

select * from citus_activate_node('new-node', 12345);

citus_activate_node

----------------------

7

(1 row)

citus_disable_node (nodename text, nodeport integer, synchronous bool) returns void

Для работы функции требуются права суперпользователя.

Функция citus_disable_node является противоположностью функции citus_activate_node. Она помечает узел как неактивный в таблице метаданных Citus pg_dist_node, временно удаляя его из кластера. Функция также удаляет все справочные таблицы с отключенного узла. Чтобы повторно активировать узел, просто запустите citus_activate_node еще раз. В качестве аргументов функция принимает dns-имя и порт подключения к PostgreSQL для рабочего узла.

Пример использования:

select * from citus_disable_node('new-node', 12345);

citus_add_secondary_node (nodename text, nodeport integer, primaryname text, primaryport integer, nodecluster name) returns integer

Для работы функции требуются права суперпользователя.

Функция citus_add_secondary_node() регистрирует новый дочерний узел в кластере для существующего основного узла. Она обновляет таблицу метаданных Citus pg_dist_node. Функция принимает на вход следующие аргументы:

nodename: DNS-имя или IP-адрес нового добавляемого дочернего узла;nodeport: порт PostgreSQL на дочернем рабочем узле;primaryname: DNS-имя или IP-адрес основного узла;primaryport: порт PostgreSQL на основном узле;nodecluster: Имя кластера. По умолчанию -default.

В результате работы функция вернет значение nodeid для добавленной в таблицу pg_dist_node строки.

Пример использования:

select * from citus_add_secondary_node('new-node', 12345, 'primary-node', 12345);

citus_add_secondary_node

---------------------------

7

(1 row)

citus_remove_node (nodename text, nodeport integer) returns void

Для работы функции требуются права суперпользователя.

Функция citus_remove_node() удаляет указанный узел из таблицы метаданных pg_dist_node. Эта функция выдаст ошибку, если на этом узле существуют сегменты объектов кластера Citus. Таким образом, прежде чем использовать эту функцию, сегменты должны быть удалены с этого узла. На вход функция принимает dns-имя и порт подключения к PostgreSQL для удаляемого рабочего узла.

Пример использования:

select citus_remove_node('new-node', 12345);

citus_remove_node

--------------------

(1 row)

citus_get_active_worker_nodes () returns setof record

Функция citus_get_active_worker_nodes() возвращает список имен активных рабочих узлов и номеров портов. В результате работы функция вернет представление с именами и портами активных рабочих узлов.

Пример использования:

SELECT * from citus_get_active_worker_nodes();

node_name | node_port

-----------+-----------

localhost | 9700

localhost | 9702

localhost | 9701

(3 rows)

citus_backend_gpid () returns bigint

Функция citus_backend_gpid() возвращает глобальный идентификатор процесса (PID) для серверной части PostgreSQL, обслуживающей текущий сеанс. GPID кодируется как nodeid узла в кластере Citus, и идентификатор процесса операционной системы(PID) PostgreSQL на этом узле. Citus расширяет функции сервера PostgreSQL pg_cancel_backend() и pg_terminate_backend(), чтобы они принимали идентификаторы GPID. В Citus вызов этих функций на одном узле может повлиять на серверную часть, работающую на другом узле. В результате работы функция вернет GPID, который вычисляется по следующей формуле - (NodeId * 10,000,000,000) + ProcessId

Пример использования:

SELECT citus_backend_gpid();

citus_backend_gpid

--------------------

10000002055

citus_check_cluster_node_health () returns setof record

Проверяет соединение между всеми узлами. Если в кластере N узлов, будет проверено все N^2 соединений между ними. Возвращает список записей, в котором есть DNS-имя исходного рабочего узла, порт PostgreSQL на исходном рабочем узле, DNS-имя конечного рабочего узла, порт на целевом рабочем узле, удалось ли установить соединение.

Пример использования:

SELECT * FROM citus_check_cluster_node_health();

from_nodename │ from_nodeport │ to_nodename │ to_nodeport │ result

---------------+---------------+-------------+-------------+--------

localhost | 1400 | localhost | 1400 | t

localhost | 1400 | localhost | 1401 | t

localhost | 1400 | localhost | 1402 | t

localhost | 1401 | localhost | 1400 | t

localhost | 1401 | localhost | 1401 | t

localhost | 1401 | localhost | 1402 | t

localhost | 1402 | localhost | 1400 | t

localhost | 1402 | localhost | 1401 | t

localhost | 1402 | localhost | 1402 | t

(9 rows)

citus_set_coordinator_host (host text, port integer, node_role noderole, node_cluster name) returns void

Эта функция необходима при добавлении рабочих узлов в кластер Citus, который изначально был создан как одноузловой кластер. Когда координатор регистрирует новый узел, он добавляет имя хоста координатора из значения citus.local_hostname(text), которое по умолчанию имеет значение localhost. Рабочий узел будет пытаться подключиться к localhost, чтобы соединиться с координатором, что, очевидно, неверно. Таким образом, системный администратор должен вызвать citus_set_coordinator_host перед вызовом citus_add_node. Функция принмает следующие аргументы:

host: DNS-имя узла-координатора;port: (необязательный параметр) Порт PostgreSQL на координаторе. По умолчанию используется значениеcurrent_setting("порт");node_role: (необязательный параметр) По умолчанию используется значениеprimary;node_cluster: (необязательный параметр) По умолчанию используется значениеdefault.

Пример использования:

-- assuming we're in a single-node cluster

-- first establish how workers should reach us

SELECT citus_set_coordinator_host('coord.example.com', 5432);

-- then add a worker

SELECT * FROM citus_add_node('worker1.example.com', 5432);

master_get_table_metadata(table_name regclass) returns setof record

Возвращает метаданные, связанные с распределением, для распределенной таблицы. Эти метаданные включают идентификатор связи, тип хранилища, метод распространения, столбец распространения, количество репликаций (не рекомендуется), максимальный размер сегмента и политику размещения сегментов для этой таблицы. По сути, эта функция запрашивает таблицы метаданных Citus, чтобы получить необходимую информацию, и объединяет ее в кортеж, прежде чем вернуть пользователю. На вход функция принимает имя таблицы, метаданные для которой нужно получить. На выходе получается представление, в котором содержаться поля:

logical_relid: идентификатор(oid) распределенной таблицы. Это значение отсылает к столбцуrelfilenodeв таблице системного каталогаpg_class;part_storage_type: Тип хранилища, используемого для таблицы. Может бытьt(стандартная таблица),f(внешняя таблица) илиc(столбчатая таблица);part_method: Метод распределения, используемый для таблицы. Должно бытьh(хеш);part_key: столбец распределения для таблицы;part_replica_count: Текущее количество репликаций сегментов (устарело);part_max_size: Текущий максимальный размер сегмента в байтах;part_placement_policy: Политика размещения сегментов, используемая для размещения сегментов таблицы. Может быть1(local-node-first) или2(round-robin).

Пример использования:

SELECT * from master_get_table_metadata('github_events');

logical_relid | part_storage_type | part_method | part_key | part_replica_count | part_max_size | part_placement_policy

---------------+-------------------+-------------+----------+--------------------+---------------+-----------------------

24180 | t | h | repo_id | 1 | 1073741824 | 2

(1 row)

get_shard_id_for_distribution_column (table_name regclass, distribution_value "any") returns bigint

Citus присваивает каждой строке распределенной таблицы сегмент на основе значения столбца распределения строки и метода распределения таблицы. В большинстве случаев точное сопоставление является детализацией низкого уровня, которую администратор базы данных может проигнорировать. Однако может оказаться полезным определить сегмент строки, либо для выполнения задач обслуживания базы данных вручную, либо просто для удовлетворения любопытства. Функция get_shard_id_for_distribution_column предоставляет эту информацию для таблиц с распределением по хешу, а также для справочных таблиц. В качестве аргументов функция принимает имя таблицы и значение столбца распределения. В результате работы функция возвращает идентификатор сегмента Citus, в котором хранятся строки по заданному значению.

Пример использования:

SELECT get_shard_id_for_distribution_column('my_table', 4);

get_shard_id_for_distribution_column

--------------------------------------

540007

(1 row)

column_to_column_name (table_name regclass, column_var_text text) returns text

Преобразует столбец partkey в pg_dist_partition в текстовое имя столбца. Это полезно для определения столбца распределения в распределенной таблице. На вход функция принимает имя распределенной таблицы и значение параметра partkey в таблице pg_dist_partition. На выходе функция возвращает текстовое имя столбца.

Пример использования:

-- get distribution column name for products table

SELECT column_to_column_name(logicalrelid, partkey) AS dist_col_name

FROM pg_dist_partition

WHERE logicalrelid='products'::regclass;

┌───────────────┐

│ dist_col_name │

├───────────────┤

│ company_id │

└───────────────┘

citus_relation_size (logicalrelid regclass) returns bigint

Возвращает информацию о пространстве на диске, используемом всеми сегментами указанной распределенной таблицы. Включает размер “основного раздела”, но не включает карту видимости и карту свободного пространства для сегментов. На вход принимает имя распределенной таблицы.

Пример использования:

SELECT pg_size_pretty(citus_relation_size('github_events'));

pg_size_pretty

--------------

23 MB

citus_table_size (logicalrelid regclass) returns bigint

Возвращает информацию о пространстве на диске, используемом всеми сегментами указанной распределенной таблицы, исключая индексы (но включая TOAST, карту свободного пространства и карту видимости). На вход принимает имя распределенной таблицы.

Пример использования:

SELECT pg_size_pretty(citus_table_size('github_events'));

pg_size_pretty

--------------

37 MB

citus_total_relation_size (logicalrelid regclass) returns bigint

Возвращает информацию о пространстве на диске, используемом всеми сегментами указанной распределенной таблицы, включая все индексы и TOAST. На вход принимает имя распределенной таблицы.

Пример использования:

SELECT pg_size_pretty(citus_total_relation_size('github_events'));

pg_size_pretty

--------------

73 MB

citus_stat_statements_reset () returns void

Удаляет все строки из citus_stat_statements. Обратите внимание, что эта функция работает независимо от pg_stat_statements_reset(). Чтобы сбросить все статистические данные, вызовите обе функции.

Пример использования:

SELECT citus_stat_statements_reset();

Функции управления кластером и восстановления

citus_move_shard_placement (shard_id bigint, source_node_name text, source_node_port integer, target_node_name text, target_node_port integer, shard_transfer_mode citus.shard_transfer_mode) returns void

Эта функция перемещает указанный сегмент (и совместно расположенные рядом с ним сегменты) с одного узла на другой. Обычно она используется косвенно во время ребалансировки сегмента, а не вызывается администратором базы данных напрямую. Существует два способа перемещения данных: блокирующий или неблокирующий. Блокирующий подход означает, что во время перемещения все изменения в сегменте приостанавливаются. Второй способ, который позволяет избежать блокировки записи в сегмент, основан на логической репликации Postgres 10+. После успешной операции перемещения сегменты в исходном узле удаляются. Если в какой-либо момент перемещение завершается неудачей, эта функция выдает ошибку и оставляет исходный и целевой узлы без изменений.

Аргументы функции:

-

shard_id: идентификатор сегмента, который необходимо переместить; -

source_node_name: DNS-имя узла, на котором находится рабочий в настоящий момент сегмент (узел «источник»); -

source_node_port: порт PostgreSQL на исходном рабочем узле; -

target_node_name: DNS-имя узла, на который будет перемещаться сегмент («целевой» узел); -

target_node_port: порт PostgreSQL на целевом рабочем узле; -

shard_transfer_mode: (Необязательно) Метод репликации, следует ли использовать логическую репликацию PostgreSQL или командуCOPYмежду рабочими узлами. Возможны следующие значения:auto: Требуется идентификатор реплики, если возможна логическая репликация, в противном случае используется ранее принятое поведение. Это значение по умолчанию;force_logical: Использовать логическую репликацию, даже если таблица не имеет идентификатора реплики. Любые инструкции по обновлению/удалению таблицы не будут выполняться во время репликации;block_writes: Использовать функциюCOPY(блокирует операции записи) для таблиц, в которых отсутствует первичный ключ или идентификатор реплики.

Пример использования:

SELECT citus_move_shard_placement(12345, 'from_host', 5432, 'to_host', 5432);

citus_rebalance_start (rebalance_strategy name, drain_only boolean, shard_transfer_mode citus.shard_transfer_mode) returns bigint

Функция citus_rebalance_start() перемещает сегменты таблицы, чтобы они были равномерно распределены между рабочими узлами. Она запускает фоновое задание для восстановления баланса и немедленно завершается. Процесс ребалансировки сначала вычисляет список перемещений, которые необходимо выполнить, чтобы обеспечить балансировку кластера в пределах заданного порога. Затем он перемещает места размещения сегментов одно за другим с исходного узла на целевой узел и обновляет соответствующие метаданные сегментов, чтобы отразить перемещение. Каждому сегменту присваивается стоимость при определении того, равномерно ли распределены сегменты. По умолчанию каждый сегмент имеет одинаковую стоимость (значение равно 1), поэтому распределение для выравнивания стоимости между рабочими узлами аналогично выравниванию количества сегментов на каждом. Стратегия ребалансировки, опирающейся на постоянную стоимость называется by_shard_count и является стратегией ребалансировки по умолчанию. Стратегия by_shard_count подходит в следующих случаях:

- сегменты примерно одинакового размера;

- сегменты получают примерно одинаковый объем трафика;

- все рабочие узлы имеют одинаковый размер/тип;

- сегменты не были привязаны к конкретным рабочим узлам.

Если какое-либо из этих предположений не выполняется, то ребалансировка by_shard_count может привести к неправильному плану. По умолчанию используется стратегия ребалансировки by_disk_size. Всегда можно настроить стратегию, используя параметр rebalance_strategy. Рекомендуется вызвать get_rebalance_table_shards_plan перед запуском citus_rebalance_start, чтобы увидеть и проверить, какие действия необходимо выполнить.

Входные аргументы:

-

rebalance_strategy: (необязательно) название стратегии в таблице стратегий ребалансировкиpg_dist_rebalance_strategy. Если этот аргумент опущен, функция выбирает стратегию по умолчанию, как указано в таблице; -

drain_only: (необязательно) При значенииtrueпереместите сегменты рабочих узлов, для которых в таблице рабочих узлов должно быть установлено значениеfalse; другие сегменты не перемещать; -

shard_transfer_mode: (необязательно) указать метод репликации - логическая репликация или командаCOPY. Этот аргумент может принимать следующие значения:auto: требовать идентификатор реплики, если возможна логическая репликация, в противном случае использовать ранее принятое поведение. Это значение по умолчанию;force_logical: использовать логическую репликацию, даже если таблица не имеет идентификатора реплики. Любые одновременные операторы изменения/удаления таблицы во время репликации завершатся ошибкой;block_writes: использовать командуCOPY(блокирующую запись) для таблиц, у которых нет первичного ключа или идентификатора реплики.

Пример использования:

SELECT citus_rebalance_start();

NOTICE: Scheduling...

NOTICE: Scheduled as job 1337.

DETAIL: Rebalance scheduled as background job 1337.

HINT: To monitor progress, run: SELECT details FROM citus_rebalance_status();

citus_rebalance_status () returns table

отслеживать ход выполнения балансировки, запущенной функцией citus_rebalance_start().

Пример использования:

-- all columns

SELECT * FROM citus_rebalance_status();

.

job_id | state | job_type | description | started_at | finished_at | details

--------+----------+-----------+---------------------------------+-------------------------------+-------------------------------+-----------

4 | running | rebalance | Rebalance colocation group 1 | 2022-08-09 21:57:27.833055+02 | 2022-08-09 21:57:27.833055+02 | { ... }

-- for details

SELECT details FROM citus_rebalance_status();

{

"phase": "copy",

"phase_index": 1,

"phase_count": 3,

"last_change":"2022-08-09 21:57:27",

"colocations": {

"1": {

"shard_moves": 30,

"shard_moved": 29,

"last_move":"2022-08-09 21:57:27"

},

"1337": {

"shard_moves": 130,

"shard_moved": 0

}

}

}

citus_rebalance_stop() returns void

Эта функция отменяет выполняемую ребалансировку, если таковая запущена.

Пример использования:

select citus_rebalance_stop();

citus_rebalance_wait() returns void

Эта функция блокируется(зависает) до завершения текущей ребалансировки. Если при вызове функции citus_rebalance_wait() отсутствует запущенная ребалансировка, функция немедленно завершается. Функция может быть полезна для сценариев НТ или сравнительного анализа.

Пример использования:

select citus_rebalance_wait();

get_rebalance_table_shards_plan(relation regclass, threshold float4, max_shard_moves int, excluded_shard_list bigint[], drain_only boolean, rebalance_strategy name)returns table

Вывести осуществляемые функцией citus_rebalance_start перемещения фрагментов, не выполняя их. Нужно учитывать, что хоть это и маловероятно, get_rebalance_table_shards_plan может выдать план, немного отличающийся от того, что будет делать вызов citus_rebalance_start с теми же аргументами. Это может произойти из–за того, что они выполняются не одновременно, поэтому данные о кластере – например, объем дискового пространства - могут отличаться между вызовами. На вход функция принимает расширенные аргументы функции citus_rebalance_start():

relation regclass;threshold float4;max_shard_moves int;excluded_shard_list bigint[];drain_only boolean;rebalance_strategy name.

В результате работы функция вернет таблицу состоящую из следующих столбцов:

table_name: Таблица, сегменты которой будут перемещены;shard: Соответствующий сегмент;shard_size: Размер в байтах;sourcename: Имя узла-источника;sourceport: Порт узла-источника;targetname: Имя узла-получателя;targetport: порт узла-получателя.

get_rebalance_progress() returns table

Как только начинается ребалансировка сегмента, функция get_rebalance_progress() отображает прогресс каждого задействованного сегмента. Она отслеживает действия, запланированные и выполненные функцией citus_rebalance_start(). Похожа на функцию citus_rebalance_status(), но возможно последняя будет проще для восприятия. В результате работы функция вернет представление из следующих полей:

sessionid: Postgres PID монитора восстановления баланса;tablename: таблица, сегменты которой перемещаются;shardid: Соответствующий сегмент;shard_size: Размер сегмента в байтах;sourcename: Имя узла-источника;sourceport: Порт исходного узла;targetname: Имя хоста конечного узла;targetport: порт конечного узла;progress:0= ожидание перемещения;1= перемещение;2= завершено;source_shard_size: Размер сегмента на исходном узле в байтах;target_shard_size: Размер сегмента на целевом узле в байтах.

Пример использования:

SELECT * FROM get_rebalance_progress();

┌───────────┬────────────┬─────────┬────────────┬───────────────┬────────────┬───────────────┬────────────┬──────────┬───────────────────┬───────────────────┐

│ sessionid │ table_name │ shardid │ shard_size │ sourcename │ sourceport │ targetname │ targetport │ progress │ source_shard_size │ target_shard_size │

├───────────┼────────────┼─────────┼────────────┼───────────────┼────────────┼───────────────┼────────────┼──────────┼───────────────────┼───────────────────┤

│ 7083 │ foo │ 102008 │ 1204224 │ n1.foobar.com │ 5432 │ n4.foobar.com │ 5432 │ 0 │ 1204224 │ 0 │

│ 7083 │ foo │ 102009 │ 1802240 │ n1.foobar.com │ 5432 │ n4.foobar.com │ 5432 │ 0 │ 1802240 │ 0 │

│ 7083 │ foo │ 102018 │ 614400 │ n2.foobar.com │ 5432 │ n4.foobar.com │ 5432 │ 1 │ 614400 │ 354400 │

│ 7083 │ foo │ 102019 │ 8192 │ n3.foobar.com │ 5432 │ n4.foobar.com │ 5432 │ 2 │ 0 │ 8192 │

└───────────┴────────────┴─────────┴────────────┴───────────────┴────────────┴───────────────┴────────────┴──────────┴───────────────────┴───────────────────┘

citus_add_rebalance_strategy (name name, shard_cost_function regproc, node_capacity_function regproc, shard_allowed_on_node_function regproc, default_threshold float4, minimum_threshold float4, improvement_threshold float4) returns void

Добавляет строку к таблице pg_dist_rebalance_strategy

Входные аргументы:

name: идентификатор новой стратегии;shard_cost_function: определяет функцию, используемую для определения «стоимости» каждого сегмента;node_capacity_function: определяет функцию для измерения пропускной способности узла;shard_allowed_on_node_function: определяет функцию, которая определяет, какие сегменты могут быть размещены на каких узлах;default_threshold: порог с плавающей точкой, который определяет, насколько точно должна быть сбалансирована совокупная стоимость сегментов между узлами;minimum_threshold: (необязательно) защитный столбец, содержащий минимальное значение, допустимое для порогового аргументаcitus_rebalance_start(). Его значение по умолчанию равно0.

citus_set_default_rebalance_strategy (name text) returns void

Устанавливает стратегию по умолчанию в таблице стратегий ребалансировки. В качестве аргумента передается имя функции для установки по умолчанию.

Пример использования:

SELECT citus_set_default_rebalance_strategy('by_disk_size');

citus_remote_connection_stats () returns setof record

Показывает количество активных подключений к каждому удаленному узлу.

Пример использования:

SELECT * from citus_remote_connection_stats();

hostname | port | database_name | connection_count_to_node

----------------+------+---------------+--------------------------

citus_worker_1 | 5432 | postgres | 3

(1 row)

citus_drain_node (nodename text, nodeport integer, shard_transfer_mode citus.shard_transfer_mode, rebalance_strategy name) returns void

Перемещает сегменты с указанного узла на другие узлы, для которых в таблице рабочих узлов должно быть установлено значение true для сегментов. Эта функция предназначена для вызова перед удалением узла из кластера, т.е. отключением физического сервера узла.

Входные аргументы:

-

nodename: имя или адрес узла; -

nodeport: порт PostgreSQL; -

shard_transfer_mode: (необязательно) указать метод репликации - логическая репликация или командаCOPY. Этот аргумент может принимать следующие значения:auto: требовать идентификатор реплики, если возможна логическая репликация, в противном случае использовать ранее принятое поведение. Это значение по умолчанию;force_logical: использовать логическую репликацию, даже если таблица не имеет идентификатора реплики. Любые одновременные операторы изменения/удаления таблицы во время репликации завершатся ошибкой;block_writes: использовать командуCOPY(блокирующую запись) для таблиц, у которых нет первичного ключа или идентификатора реплики;

-

rebalance_strategy: Стратегия ребалансировки(из таблицы стратегий).

Пример использования:

Вот типичные шаги для удаления отдельного узла:

-

Очистите узел.

SELECT * FROM citus_drain_node('<IP-адрес>', 5432); -

Дождитесь завершения команды.

-

Удалите узел.

При удалении нескольких узлов рекомендуется использовать citus_rebalance_start вместо этого. Это позволит Citus планировать заранее и перемещать сегменты минимальное количество раз:

-

Выполните это для каждого узла, который необходимо удалить:

SELECT * FROM citus_set_node_property(node_hostname, node_port, 'shouldhaveshards', false); -

Очистите их все сразу с помощью

citus_rebalance_start:SELECT * FROM citus_rebalance_start(drain_only := true); -

Дождитесь завершения ребалансировки.

-

Удалите узлы.

isolate_tenant_to_new_shard (table_name regclass, tenant_id "any", cascade_option text, shard_transfer_mode citus.shard_transfer_mode) returns bigint

Создает новый сегмент для хранения строк с определенным значением в столбце распределения. Это особенно удобно в случае использования Citus с несколькими арендаторами, когда крупный клиент может быть размещен отдельно на своем собственном сегменте и, в конечном счете, на своем собственном физическом узле.

Аргументы:

-

table_name: имя таблицы для получения нового сегмента; -

tenant_id: Значение столбца распределения, которое будет присвоено новому сегменту; -

cascade_option: (необязательно) Если установлено значениеCASCADE, также изолируются сегменты всех таблиц связанных с текущей таблицей в таблице совместного размещения; -

shard_transfer_mode: (необязательно) указать метод репликации - логическая репликация или командаCOPY. Этот аргумент может принимать следующие значения:auto: требовать идентификатор реплики, если возможна логическая репликация, в противном случае использовать ранее принятое поведение. Это значение по умолчанию;force_logical: использовать логическую репликацию, даже если таблица не имеет идентификатора реплики. Любые одновременные операторы изменения/удаления таблицы во время репликации завершатся ошибкой;block_writes: использовать командуCOPY(блокирующую запись) для таблиц, у которых нет первичного ключа или идентификатора реплики.

Пример использования:

SELECT isolate_tenant_to_new_shard('lineitem', 135);

┌─────────────────────────────┐

│ isolate_tenant_to_new_shard │

├─────────────────────────────┤

│ 102240 │

└─────────────────────────────┘

citus_create_restore_point (name text) returns pg_lsn

Временно блокирует запись в кластер и создает именованную точку восстановления на всех узлах. Эта функция аналогична функции pg_create_restore_point, но применяется ко всем узлам и обеспечивает согласованность точки восстановления на всех узлах. Эта функция хорошо подходит для оперативного восстановления и разветвления кластера. В качестве аргумента функция принимает имя точки восстановления. В результате своей работы функция вернет lsn в файле WAL узла координатора.

Пример использования:

select citus_create_restore_point('foo');

┌────────────────────────────┐

│ citus_create_restore_point │

├────────────────────────────┤

│ 0/1EA2808 │

└────────────────────────────┘

Описание таблиц и представлений

Метаданные координатора

Citus делит каждую распределенную таблицу на несколько логических сегментов на основе столбца распределения. Затем координатор поддерживает таблицы метаданных для отслеживания статистики и информации о работоспособности и местоположении этих сегментов. В этом разделе описывается каждая из этих таблиц метаданных и их схему. Эти таблицы можно проматривать с помощью SQL после входа в узел-координатор.

pg_dist_partition

Таблица pg_dist_partition хранит метаданные о том, какие таблицы в базе данных являются распределенными. Для каждой распределенной таблицы в ней также хранится информация о методе распределения и подробная информация о столбце распределения.

| Имя | Тип | Описание |

|---|---|---|

logicalrelid | regclass | Распределенная таблица, которой соответствует эта строка. Это значение ссылается на столбец relfilenode в таблице системного каталога pg_class |

partmethod | char | Метод, используемый для разделения/распределения. Значения этого столбца, соответствующие различным методам распределения, следующие: хеш: hсправочная таблица: n |

partkey | text | Подробная информация о столбце распределения, включая номер столбца, его тип и другую соответствующую информацию |

colocationid | integer | Группа совместного размещения, к которой принадлежит эта таблица. Таблицы в одной группе позволяют совместно размещать объединения и распределять сводные данные среди других оптимизаций. Это значение ссылается на столбец идентификатора colocation в таблице pg_dist_colocation |

repmodel | char | Метод, используемый для репликации данных. Значения этого столбца соответствуют различным методам репликации : потоковая репликация PostgreSQL: sдвухэтапная фиксация (для справочных таблиц): t |

Пример:

SELECT * from pg_dist_partition;

logicalrelid | partmethod | partkey | colocationid | repmodel

---------------+------------+------------------------------------------------------------------------------------------------------------------------+--------------+----------

github_events | h | {VAR :varno 1 :varattno 4 :vartype 20 :vartypmod -1 :varcollid 0 :varlevelsup 0 :varnoold 1 :varoattno 4 :location -1} | 2 | s

(1 row)

pg_dist_shard

Таблица pg_dist_shard хранит метаданные об отдельных сегментах таблицы. Это включает информацию о том, к какой распределенной таблице принадлежит сегмент, и статистические данные о столбце распределения для этого сегмента. В случае таблиц с распределенным хешем это диапазоны токенов хеша, назначенные этому сегменту. Эти статистические данные используются для удаления несвязанных фрагментов во время запросов SELECT.

| Имя | Тип | Описание |

|---|---|---|

logicalrelid | regclass | Распределенная таблица, которой соответствует эта строка. Это значение ссылается на столбец relfilenode в таблице системного каталога pg_class |

shardid | bigint | Глобальный уникальный идентификатор присвоенный сегменту |

shardstorage | char | Тип хранилища используемый сегментом |

shardminvalue | text | Для таблиц, распределенных по хешу, минимальное значение токена хеша присвоенное сегменту (включительно) |

shardmaxvalue | text | Для таблиц, распределенных по хешу, максимальное значение токена хеша присвоенное сегменту (включительно) |

Столбец shardstorage в pg_dist_shared указывает тип хранилища, используемого для сегмента. Ниже приведен краткий обзор различных типов общего хранилища и их представление.

| Тип хранилища | Значение поля shardstorage | Описание |

|---|---|---|

TABLE | t | Указывает, что сегмент хранит данные, принадлежащие обычной распределенной таблице. |

COLUMNAR | c | Указывает, что сегмент хранит колоночные данные. (Используется распределенными таблицами cstore_fdw) |

FOREIGN | f | Указывает, что сегмент хранит внешние данные. (Используется распределенными таблицами file_fdw) |

Пример:

SELECT * from pg_dist_shard;

logicalrelid | shardid | shardstorage | shardminvalue | shardmaxvalue

---------------+---------+--------------+---------------+---------------

github_events | 102026 | t | 268435456 | 402653183

github_events | 102027 | t | 402653184 | 536870911

github_events | 102028 | t | 536870912 | 671088639

github_events | 102029 | t | 671088640 | 805306367

(4 rows)

citus_shards

В дополнение к таблице метаданных сегмента низкого уровня, описанной выше, Citus предоставляет представление citus_shards, позволяющее легко проверить:

- где находится каждый сегмент (узел и порт);

- к какому типу таблицы он принадлежит;

- его размер.

Это представление помогает проверять сегменты, чтобы, помимо прочего, обнаружить любые несоответствия в размерах узлов.

Пример:

SELECT * FROM citus_shards;

table_name | shardid | shard_name | citus_table_type | colocation_id | nodename | nodeport | shard_size

------------+---------+--------------+------------------+---------------+-----------+----------+------------

dist | 102170 | dist_102170 | distributed | 34 | localhost | 9701 | 90677248

dist | 102171 | dist_102171 | distributed | 34 | localhost | 9702 | 90619904

dist | 102172 | dist_102172 | distributed | 34 | localhost | 9701 | 90701824

dist | 102173 | dist_102173 | distributed | 34 | localhost | 9702 | 90693632

ref | 102174 | ref_102174 | reference | 2 | localhost | 9701 | 8192

ref | 102174 | ref_102174 | reference | 2 | localhost | 9702 | 8192

dist2 | 102175 | dist2_102175 | distributed | 34 | localhost | 9701 | 933888

dist2 | 102176 | dist2_102176 | distributed | 34 | localhost | 9702 | 950272

dist2 | 102177 | dist2_102177 | distributed | 34 | localhost | 9701 | 942080

dist2 | 102178 | dist2_102178 | distributed | 34 | localhost | 9702 | 933888

Поле colocation_id ссылается на группу совместного размещения.

pg_dist_placement

Таблица pg_dist_placement отслеживает расположение сегментов на рабочих узлах. Соответствие сегмента определенному узлу называется размещением сегмента. В этой таблице хранится информация о работоспособности и местоположении каждого сегмента.

| Имя | Тип | Описание |

|---|---|---|

placementid | bigint | Уникальный автоматически сгенерированный идентификатор для каждого отдельного места размещения |

shardid | bigint | Идентификатор сегмента, связанный с этим размещением. Это значение ссылается на столбец shardid в таблице каталога pg_dist_shared |

shardstate | int | Описывает состояние этого размещения. Различные состояния сегмента обсуждаются в разделе ниже |

shardlength | bigint | Для таблиц распределенных по хешу здесь будет ноль |

groupid | int | Идентификатор, используемый для обозначения группы из одного основного сервера и нуля или более дополнительных серверов |

SELECT * from pg_dist_placement;

placementid | shardid | shardstate | shardlength | groupid

-------------+---------+------------+-------------+---------

1 | 102008 | 1 | 0 | 1

2 | 102008 | 1 | 0 | 2

3 | 102009 | 1 | 0 | 2

4 | 102009 | 1 | 0 | 3

5 | 102010 | 1 | 0 | 3

6 | 102010 | 1 | 0 | 4

7 | 102011 | 1 | 0 | 4

Начиная с Citus 7.0, аналогичная таблица pg_dist_shard_placement устарела. Она включала имя узла и порт для каждого размещения:

SELECT * from pg_dist_shard_placement;

shardid | shardstate | shardlength | nodename | nodeport | placementid

---------+------------+-------------+-----------+----------+-------------

102008 | 1 | 0 | localhost | 12345 | 1

102008 | 1 | 0 | localhost | 12346 | 2

102009 | 1 | 0 | localhost | 12346 | 3

102009 | 1 | 0 | localhost | 12347 | 4

102010 | 1 | 0 | localhost | 12347 | 5

102010 | 1 | 0 | localhost | 12345 | 6

102011 | 1 | 0 | localhost | 12345 | 7

Теперь эта информация доступна путем объединения pg_dist_placement с pg_dist_node по полю groupid. Для обеспечения совместимости Citus по-прежнему предоставляет pg_dist_shard_placement в качестве представления. Однако рекомендуется, по возможности, использовать новые, более нормализованные таблицы.

pg_dist_node

Таблица pg_dist_node содержит информацию о рабочих узлах в кластере.

| Имя | Тип | Описание |

|---|---|---|

nodeid | int | Автоматически сгенерированный идентификатор узла |

groupid | int | Идентификатор, используемый для обозначения группы из одного основного сервера и нуля или более дополнительных серверов. По умолчанию он совпадает с идентификатором узла |

nodename | text | DNS-имя или IP-адрес рабочего узла |

nodeport | int | Порт PostgreSQL рабочего узла |

noderack | text | (Необязательно) Информация о размещении стойки для рабочего узла |

hasmetadata | boolean | Зарезервированое для внутреннего использования поле |

isactive | boolean | Активен ли узел, принимающий размещения сегментов |

noderole | text | Является ли узел первичным или вторичным |

nodecluster | text | Имя кластера, в который входит данный узел |

metadatasynced | boolean | Зарезервированое для внутреннего использования поле |

shouldhaveshards | boolean | Если значение равно false, сегменты будут перемещены с узла (удалены) при ребалансировке, и сегменты из новых распределенных таблиц не будут размещены на узле, если только они не будут размещены совместно с уже существующими сегментами |

Пример:

SELECT * from pg_dist_node;

nodeid | groupid | nodename | nodeport | noderack | hasmetadata | isactive | noderole | nodecluster | metadatasynced | shouldhaveshards